4D Trajectory Prediction of Continuous Descent Operation in Congested Terminal Control Area

-

摘要:

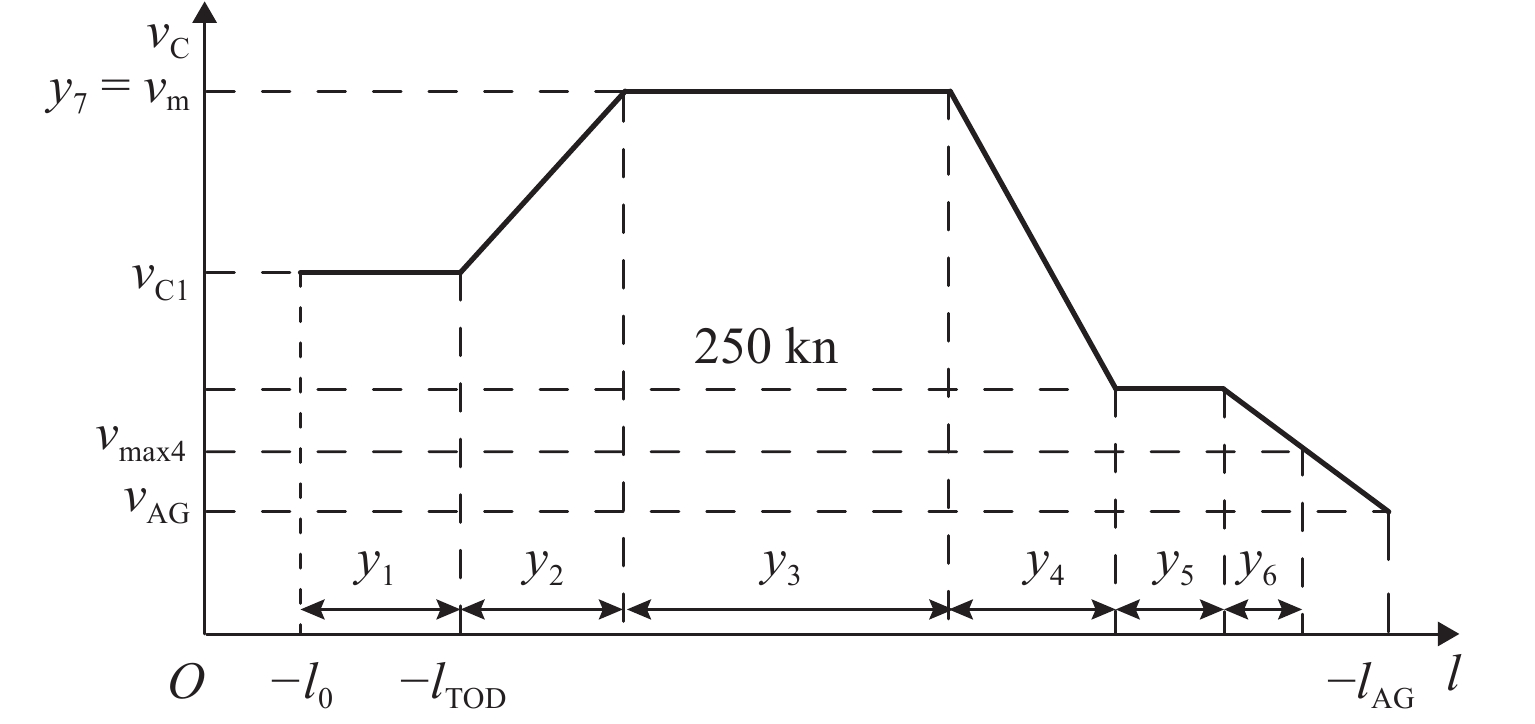

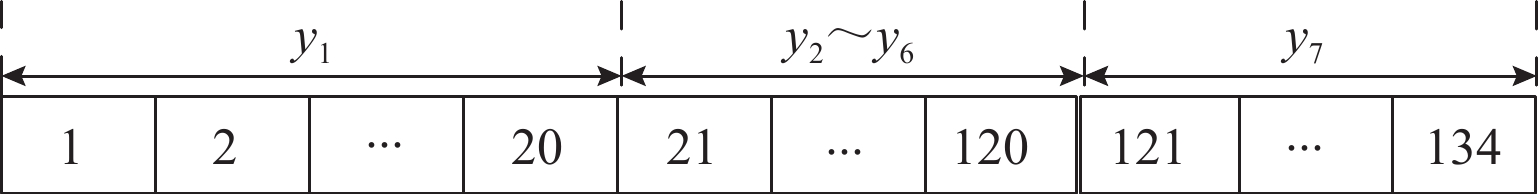

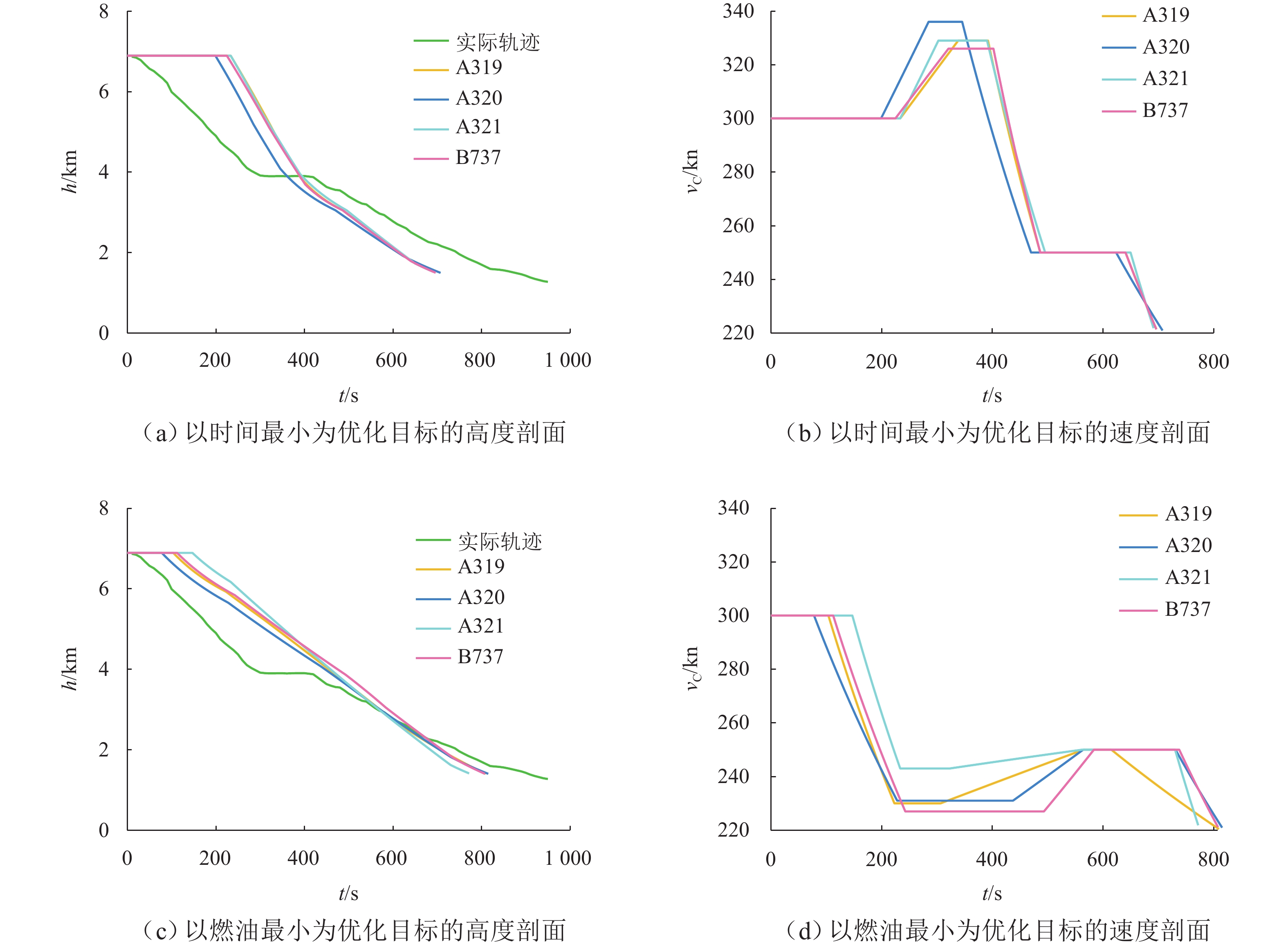

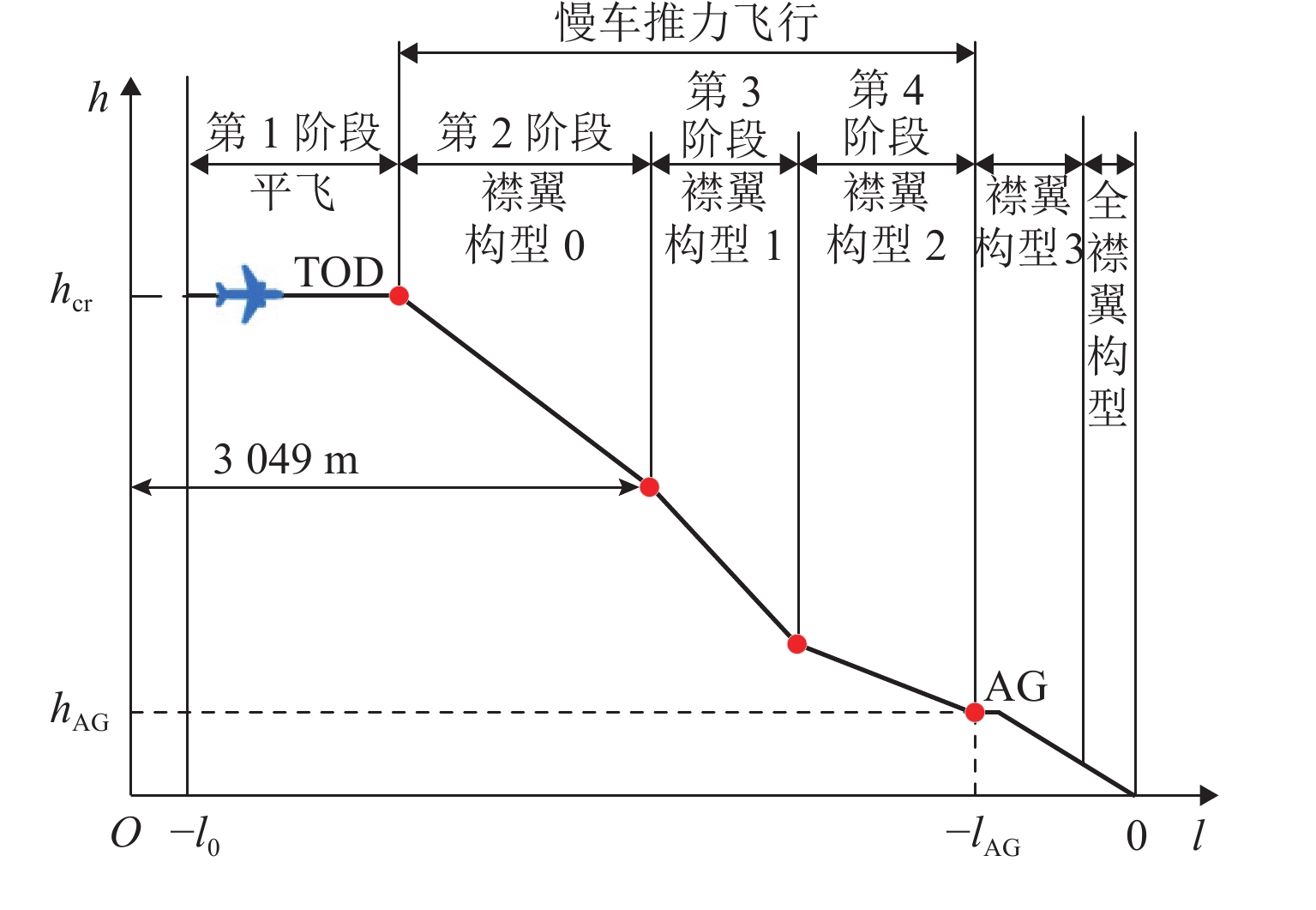

为在繁忙终端区实施连续下降运行(CDO)并估算其二氧化碳减排成效,提出一种基于数据驱动和最优控制理论相结合的连续下降运行4D轨迹预测方法. 首先,通过近邻传播轨迹聚类方法对典型进场水平路径进行识别;然后,以典型进场水平路径为依据,分别以最小时间和最小燃油为目标,建立垂直剖面连续下降运行多阶段最优控制模型,并提出一种基于遗传算法的最优控制模型求解新方法(GACDO);最后,利用终端区实际轨迹数据,开展典型进场水平路径识别和连续下降运行模式下的4D轨迹预测与减排收益比较实验. 结果表明:该方法能获得理想的连续下降运行4D轨迹;以最小时间为优化目标时,平均运行时间和二氧化碳排放分别减少26%和8%;以最小油耗为优化目标时,运行时间和二氧化碳排放分别减少17%和20%.

Abstract:In order to implement continuous descent operation (CDO) in a congested terminal control area and estimate its CO2 emission reduction benefits, a 4D trajectory prediction method for CDO based on data drive and optimal control theory was proposed. Firstly, the affinity propagation trajectory clustering method was employed to recognize typical horizontal arrival routes. According to typical horizontal arrival routes, a multi-phase optimal control model for CDO in vertical profiles was established, with the objectives of minimizing time and fuel consumption. Additionally, a novel solving method, namely genetic algorithm-based CDO (GACDO) for optimal control model was proposed. Finally, 4D trajectory prediction and emission reduction benefit comparison experiments in typical horizontal arrival route identification and CDO modes were conducted by using actual trajectory data in the terminal control area. The experimental results show that ideal 4D trajectories for CDO can be achieved. With the minimum time as the optimization objective, the average operation time and CO2 emission are reduced by 26% and 8%, respectively. With the minimum fuel consumption as the optimization objective, the operation time and CO2 emission are decreased by 17% and 20%, respectively.

-

表 1 不同机型CDO预测飞行时间与燃油消耗对比

Table 1. Comparison of predicted flight time and fuel consumption for CDO of different aircraft types

机型 预测方法 最小时间 最小燃油 lTOD/km 燃油/kg CO2/kg 飞行时间/s lTOD/km 燃油/kg CO2/kg 飞行时间/s A319 实际轨迹 170.9 538.3 950 170.9 538.3 950 GA 算法 −100.0 158.2 498.3 697 −127.7 127.3 400.9 810 A320 实际轨迹 192.6 606.7 950 192.6 606.7 950 GA 算法 −107.4 180.3 567.9 708 −133.3 161.4 508.4 815 A321 实际轨迹 266.4 839.1 950 266.4 839.1 950 GA 算法 −100.0 235.7 724.4 691 −118.5 226.6 713.7 772 B737 实际轨迹 199.5 628.4 950 199.5 628.4 950 GA 算法 −101.8 178.2 561.3 697 −125.9 153.2 482.5 808 -

[1] SÁEZ R, PRATS X, POLISHCHUK T, et al. Traffic synchronization in terminal airspace to enable continuous descent operations in trombone sequencing and merging procedures: an implementation study for Frankfurt Airport[J]. Transportation Research Part C: Emerging Technologies, 2020, 121: 102875.1-102875.23. doi: 10.1016/j.trc.2020.102875 [2] ZENG W L, CHU X, XU Z F, et al. Aircraft 4D trajectory prediction in civil aviation: a review[J]. Aerospace, 2022, 9(2): 91.1-91.19. doi: 10.3390/aerospace9020091 [3] 王超,郭九霞,沈志鹏. 基于基本飞行模型的4D航迹预测方法[J]. 西南交通大学学报,2009,44(2): 295-300. doi: 10.3969/j.issn.0258-2724.2009.02.028WANG Chao, GUO Jiuxia, SHEN Zhipeng. Prediction of 4D trajectory based on basic flight models[J]. Journal of Southwest Jiaotong University, 2009, 44(2): 295-300. doi: 10.3969/j.issn.0258-2724.2009.02.028 [4] 张军峰,蒋海行,武晓光,等. 基于BADA及航空器意图的四维航迹预测[J]. 西南交通大学学报,2014,49(3): 553-558. doi: 10.3969/j.issn.0258-2724.2014.03.028ZHANG Junfeng, JIANG Haixing, WU Xiaoguang, et al. 4D trajectory prediction based on BADA and aircraft intent[J]. Journal of Southwest Jiaotong University, 2014, 49(3): 553-558. doi: 10.3969/j.issn.0258-2724.2014.03.028 [5] 王莉莉,刘鑫宇. 基于自主改航的交叉航班流预先冲突解脱研究[J/OL]. 西南交通大学学报,1-9[2024-12-05]. http://kns.cnki.net/kcms/detail/51.1277.U.20240322.1643.006.html.WANG Lili, Liu xinyu, A study on pre-conflict resolution of cross-flight streams based on autonomous re-routing[J/OL] Journal of Southwest Jiaotong University, 1-9[2024-12-05]. http://kns.cnki.net/kcms/detail/51.1277.U.20240322.1643.006.html. [6] ZHANG J F, LIU J, HU R, et al. Online four dimensional trajectory prediction method based on aircraft intent updating[J]. Aerospace Science and Technology, 2018, 77: 774-787. doi: 10.1016/j.ast.2018.03.037 [7] FRANCO A, RIVAS D, VALENZUELA A. Probabilistic aircraft trajectory prediction in cruise flight considering ensemble wind forecasts[J]. Aerospace Science and Technology, 2018, 82/83: 350-362. doi: 10.1016/j.ast.2018.09.020 [8] DANCILA R I, BOTEZ R M. New atmospheric data model for constant altitude accelerated flight performance prediction calculations and flight trajectory optimization algorithms[J]. Proceedings of the Institution of Mechanical Engineers, Part G: Journal of Aerospace Engineering, 2021, 235(4): 405-426. doi: 10.1177/0954410020945555 [9] ZENG W L, QUAN Z B, ZHAO Z Y, et al. A deep learning approach for aircraft trajectory prediction in terminal airspace[J]. IEEE Access, 2020, 8: 151250-151266. doi: 10.1109/ACCESS.2020.3016289 [10] WU X P, YANG H Y, CHEN H, et al. Long-term 4D trajectory prediction using generative adversarial networks[J]. Transportation Research Part C: Emerging Technologies, 2022, 136: 103554.1-103554.13. doi: 10.1016/j.trc.2022.103554 [11] MA L, TIAN S. A hybrid CNN-LSTM model for aircraft 4D trajectory prediction[J]. IEEE Access, 2020, 8: 134668-134680. doi: 10.1109/ACCESS.2020.3010963 [12] DHIEF I, WANG Z, LIANG M, et al. Predicting aircraft landing time in extended-TMA using machine learning methods[C]//Proceedings of the 9th International Conference for Research in Air Transportation (ICRAT). Florida: [s.n.], 2020: 23-26. [13] ROCHA MURCA M C, DE OLIVEIRA M. A data-driven probabilistic trajectory model for predicting and simulating terminal airspace operations[C]//2020 AIAA/IEEE 39th Digital Avionics Systems Conference (DASC). San Antonio: IEEE, 2020: 1-7. [14] PARK S G, CLARKE J P. Optimal control based vertical trajectory determination for continuous descent arrival procedures[J]. Journal of Aircraft, 2015, 52(5): 1469-1480. doi: 10.2514/1.C032967 [15] MA L B, TIAN Y G, ZHANG Y, et al. Trajectory optimization of aircraft for a continuous descent continuous procedure[C]//2020 Chinese Automation Congress (CAC). Shanghai: IEEE, 2020: 2063-2067. [16] GONZÁLEZ-ARRIBAS D, SOLER M, SANJURJO-RIVO M. Robust aircraft trajectory planning under wind uncertainty using optimal control[J]. Journal of Guidance, Control, and Dynamics, 2017, 41(3): 673-688. [17] ZENG W L, XU Z F, CAI Z P, et al. Aircraft trajectory clustering in terminal airspace based on deep autoencoder and Gaussian mixture model[J]. Aerospace, 2021, 8(9): 266.1-266.18. doi: 10.3390/aerospace8090266 [18] FREY B J, DUECK D. Clustering by passing messages between data points[J]. Science, 2007, 315(5814): 972-976. doi: 10.1126/science.1136800 [19] NUIC A. User manual for the base of aircraft data (BADA) revision 3.6[EB/OL]. (2004-10-14)[2023-05-05]. https://www.eurocontrol.int/publication/user-manual-base-aircraft-data-bada. -

下载:

下载: