Sensorless Control of Permanent Magnet Synchronous Motor Based on Improved Super-Twisting Sliding Mode Observer

-

摘要:

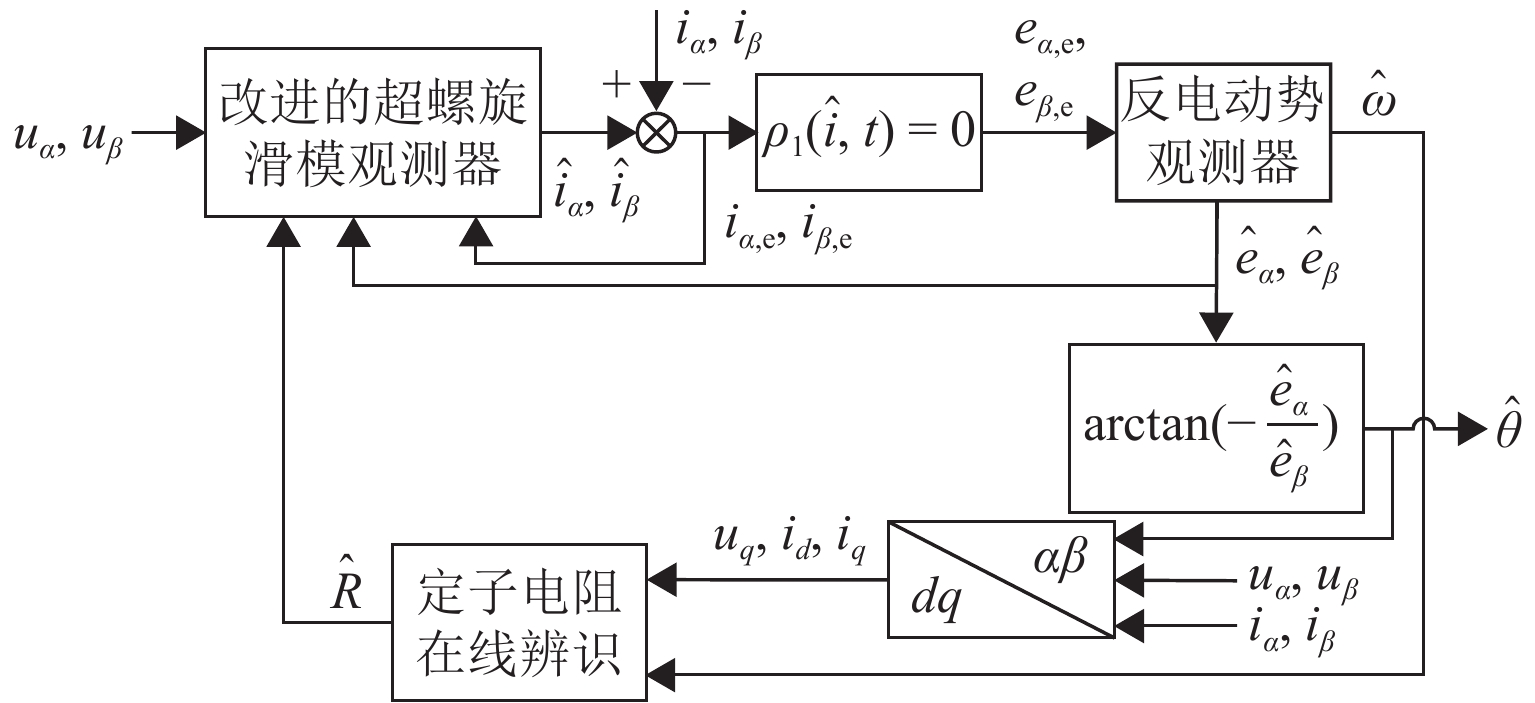

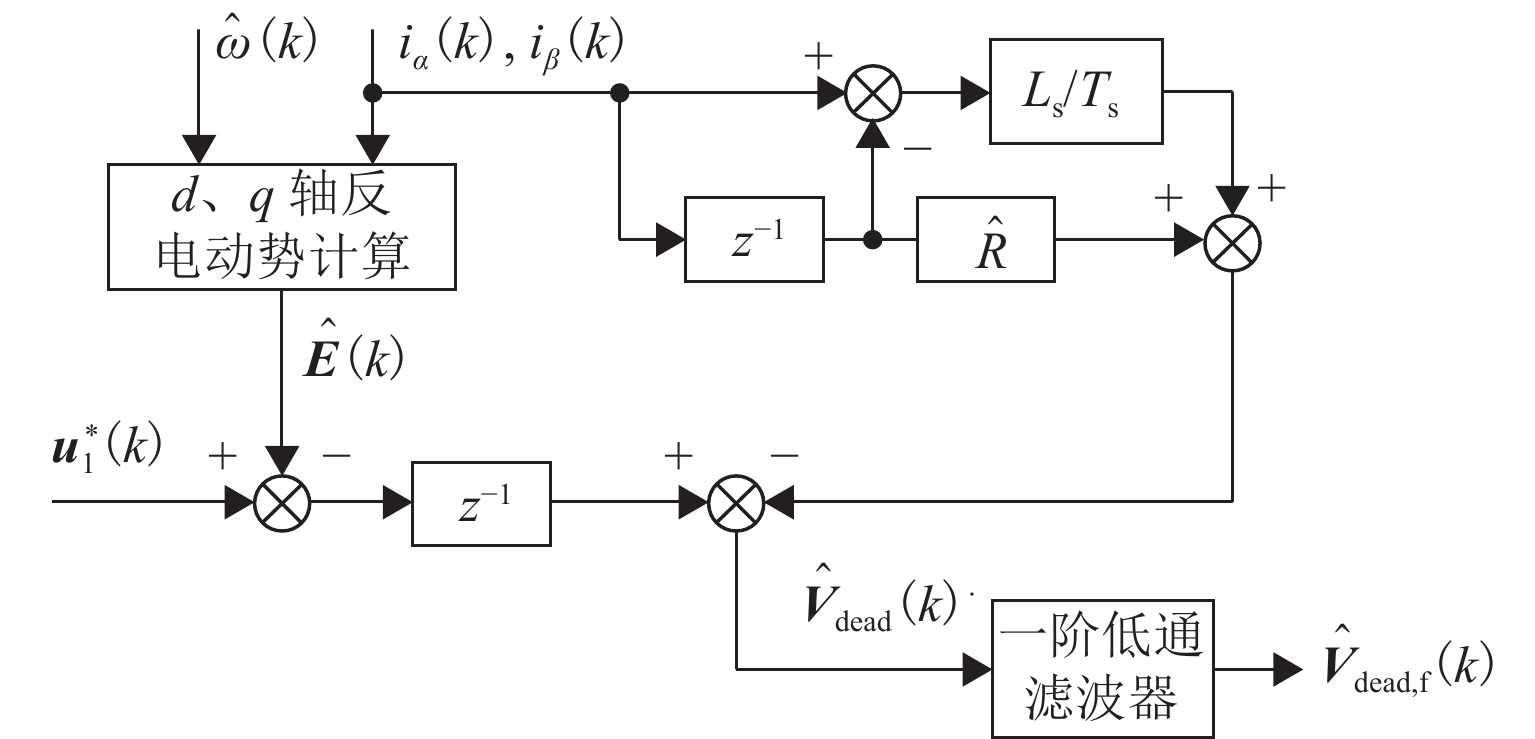

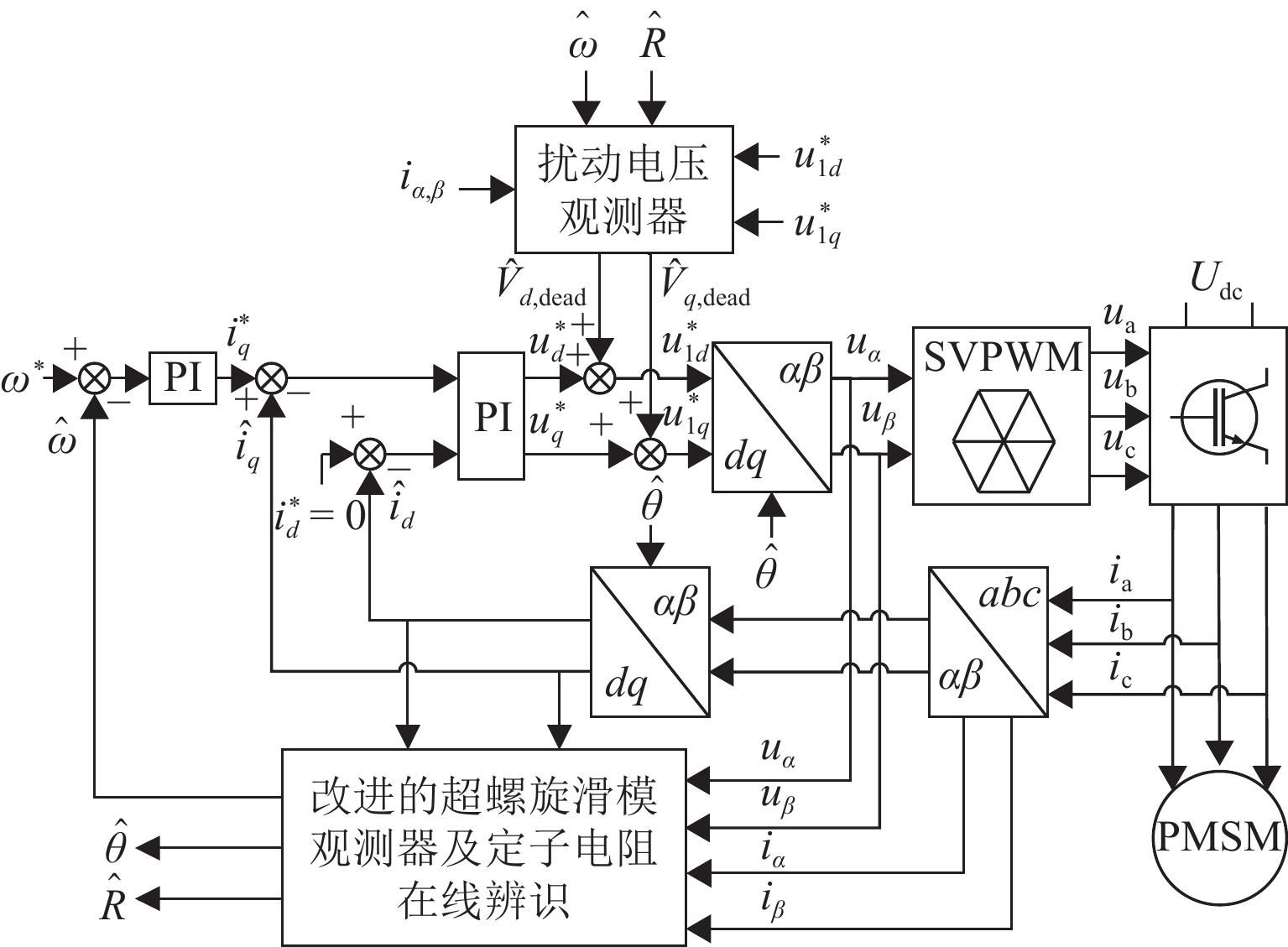

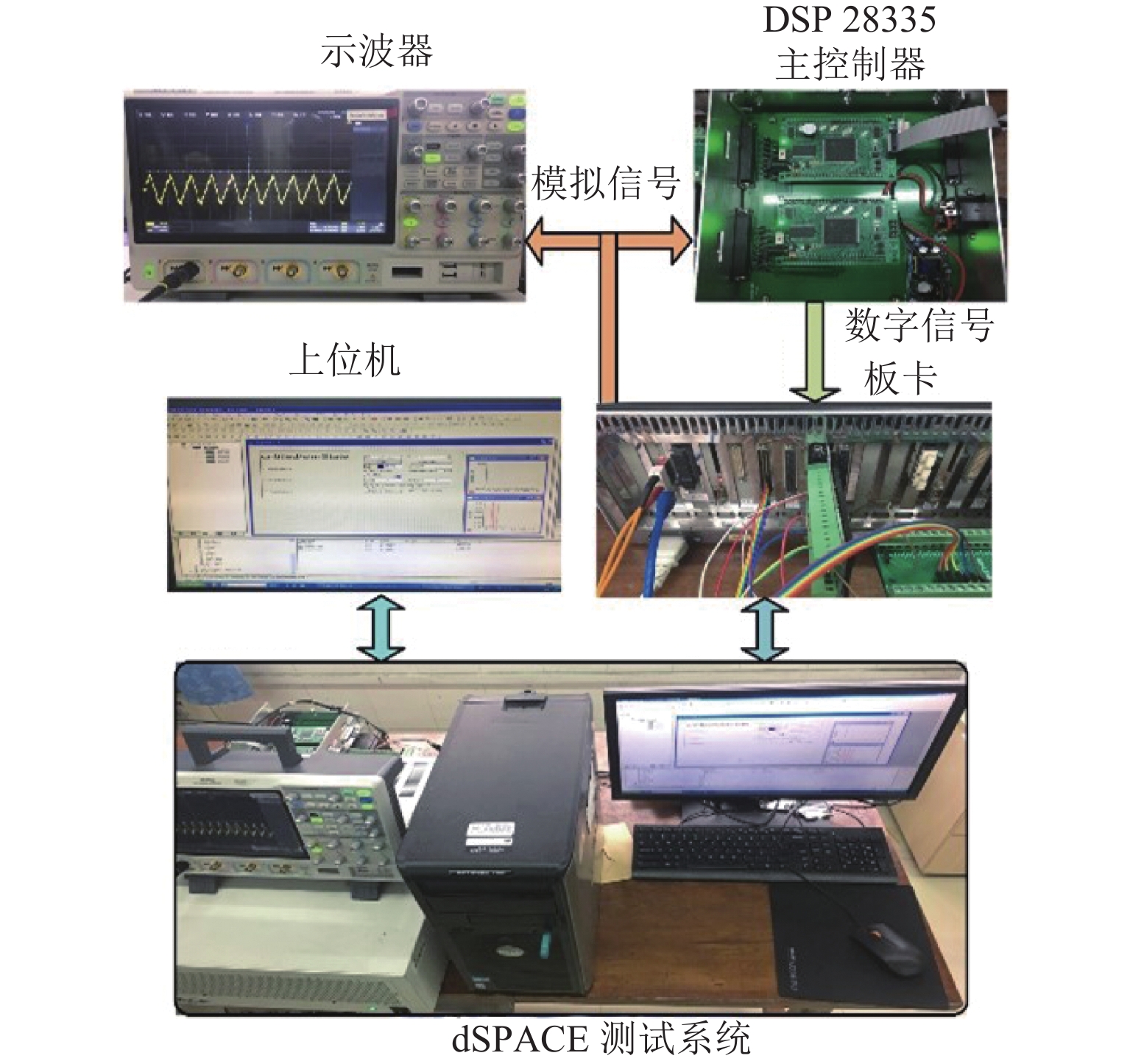

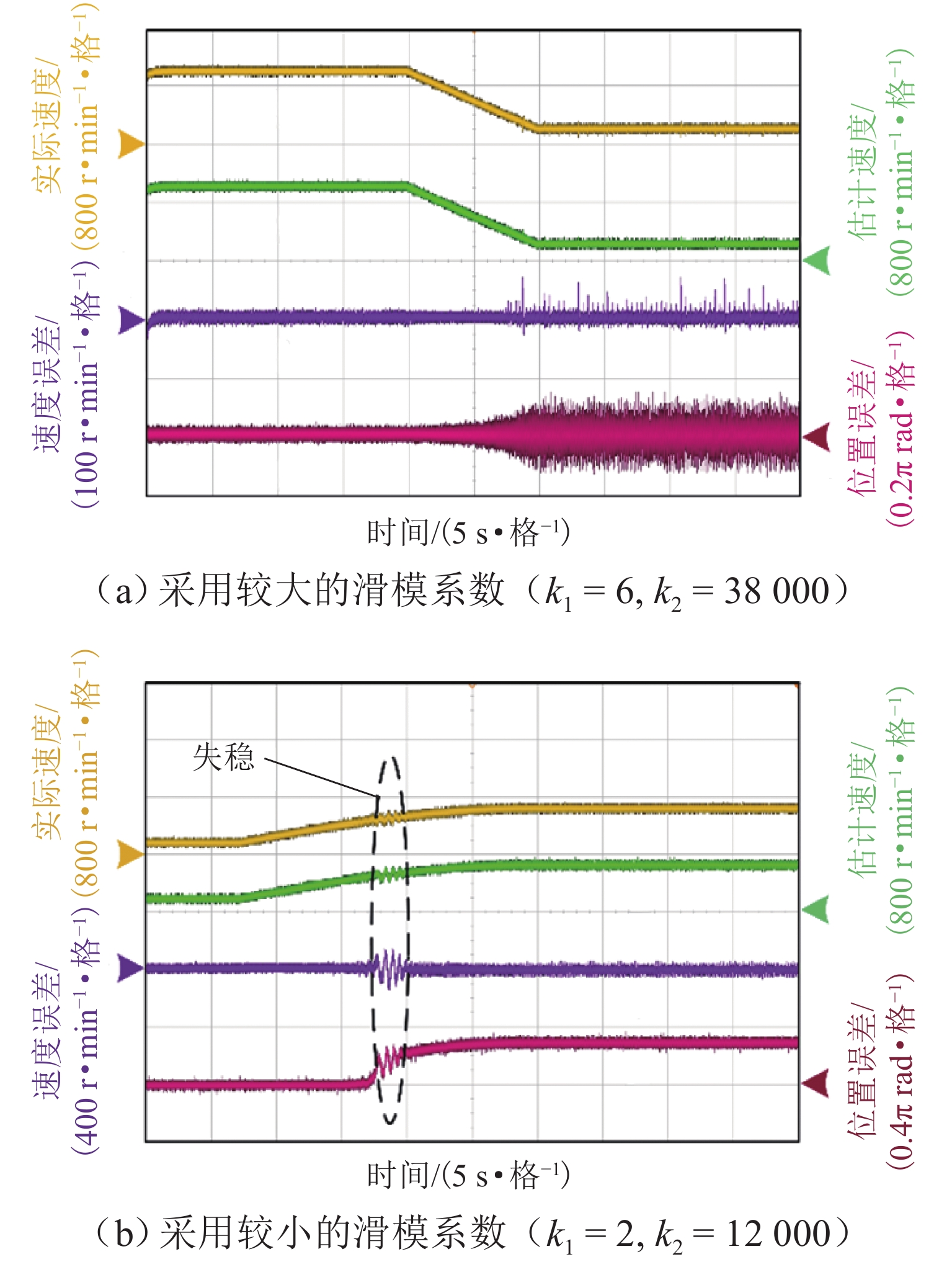

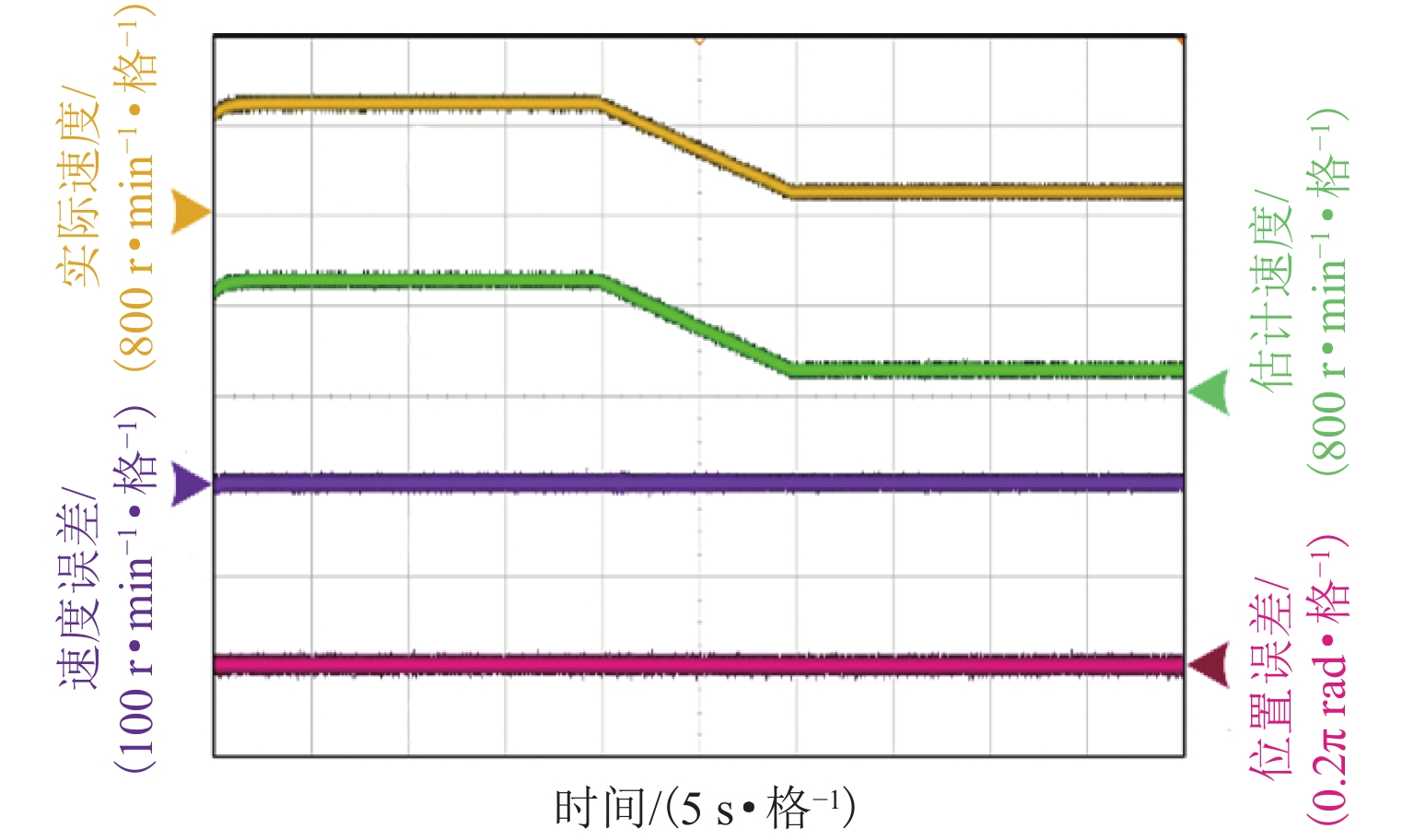

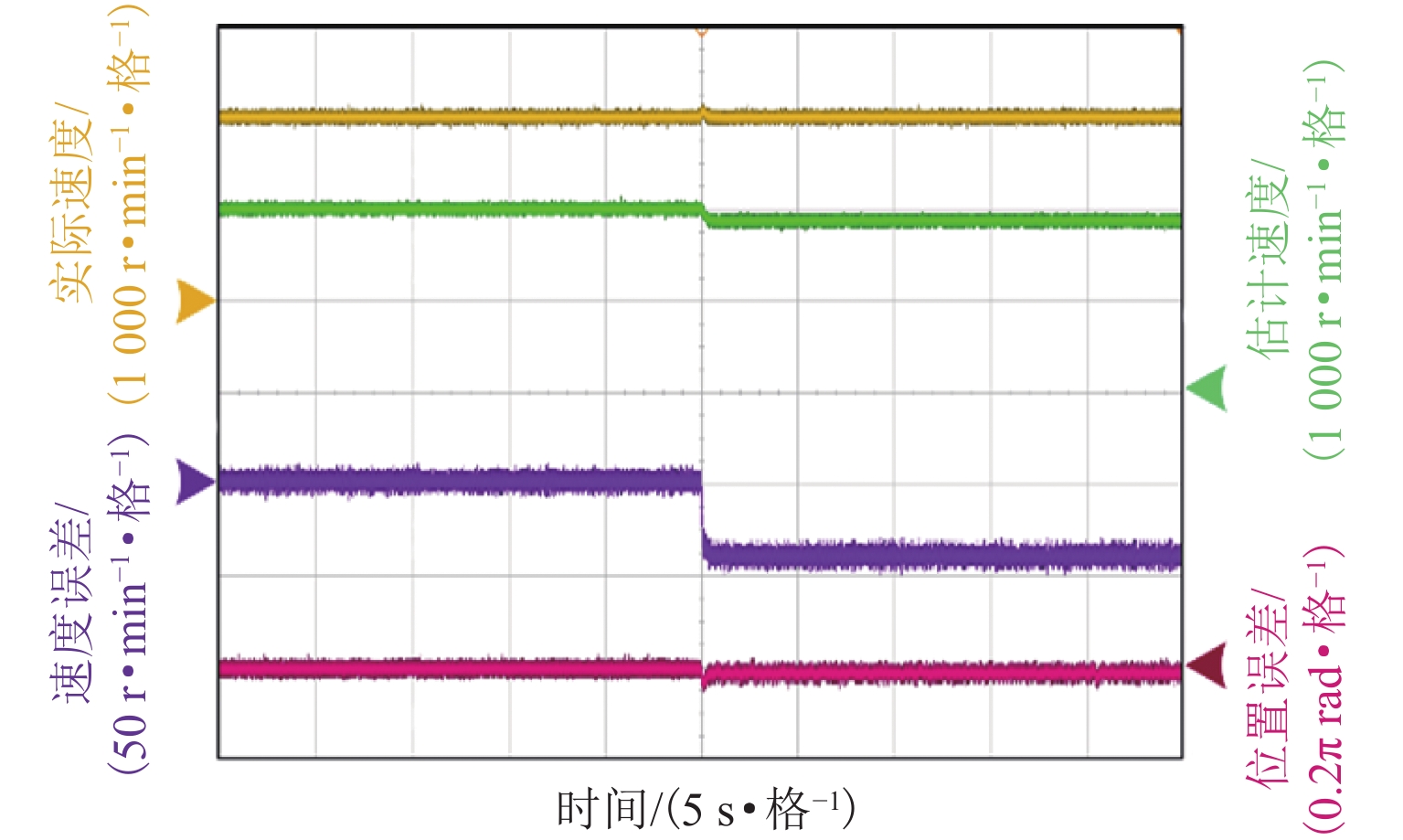

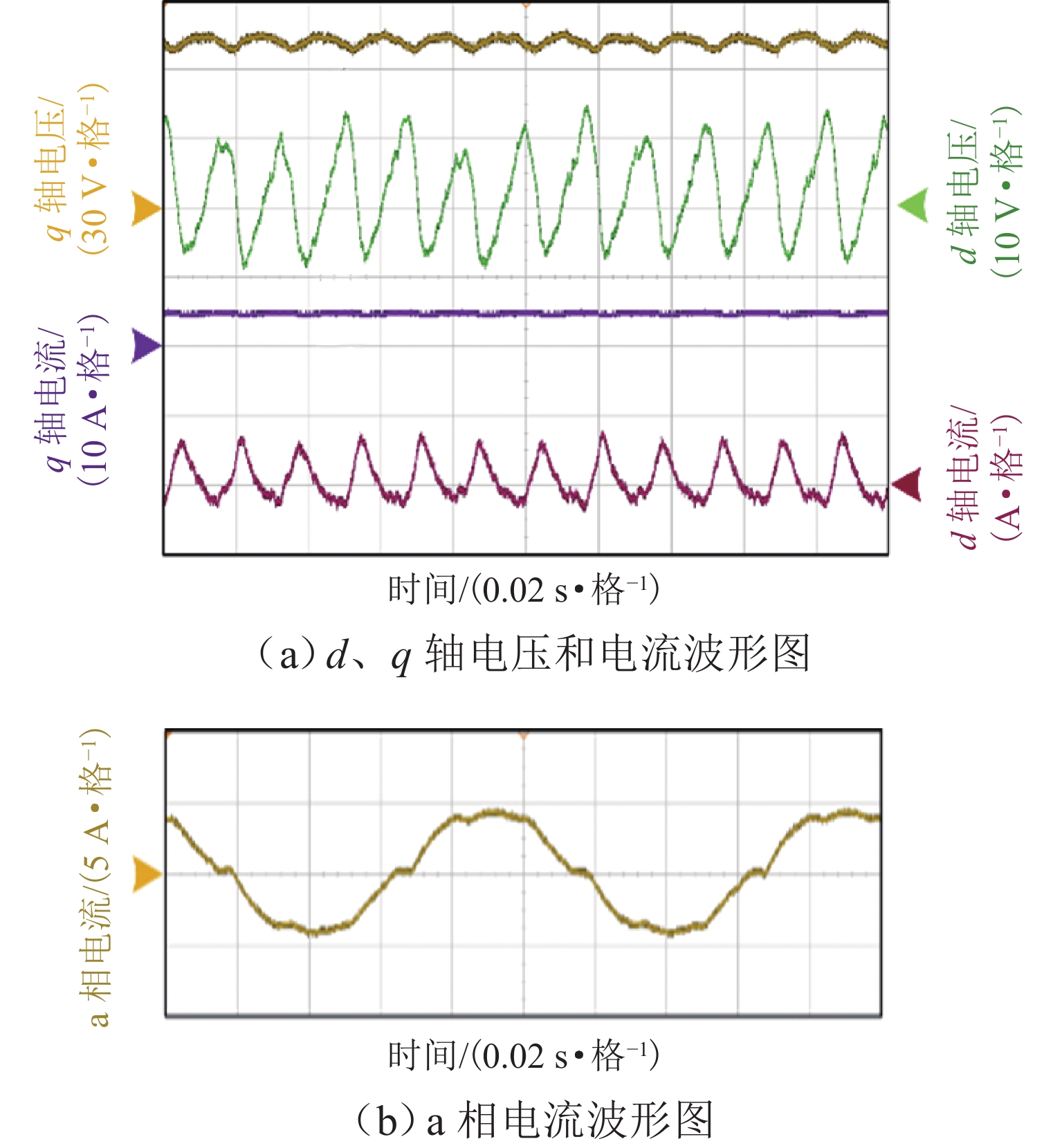

在无传感器控制宽调速范围内,传统super-twisting二阶滑模观测器算法在永磁同步电机中存在转子位置估计误差随速度变化而发生抖动的问题. 为减小转子位置估计误差并提升电机调速控制性能,本文基于双曲函数提出一种改进的滑模观测器,并设计定子电阻的在线辨识方案,同时开发扰动电压观测器以在线估计逆变器非线性引起的失真电压;最后,通过电机硬件在环实验测试进行验证. 测试结果表明:位置估计误差减小7.6%,速度估计精度提高5.8%.

-

关键词:

- 永磁同步电机 /

- 无传感器控制 /

- 改进super-twisting算法 /

- 定子电阻在线辨识 /

- 逆变器非线性补偿

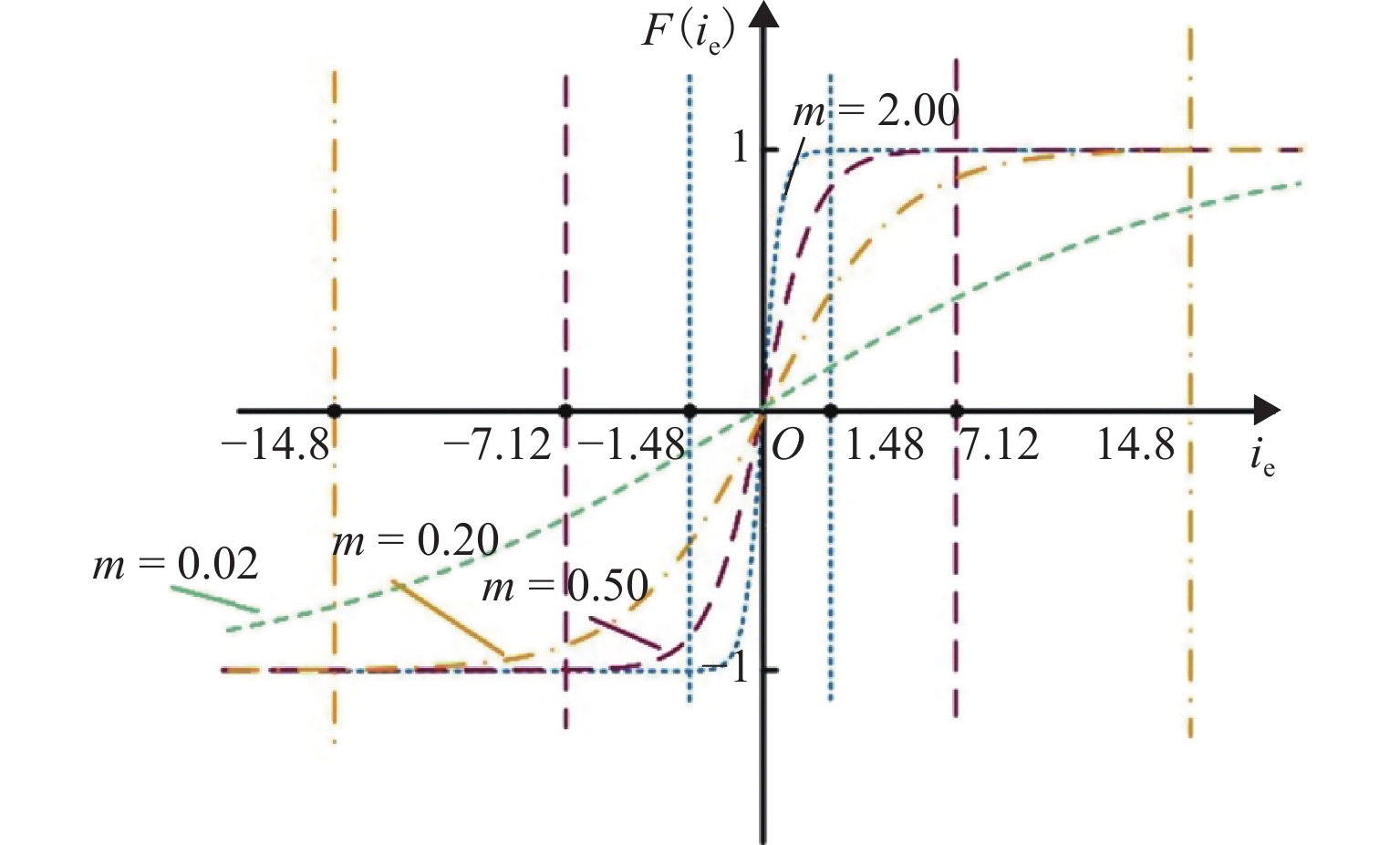

Abstract:In the wide speed range of sensorless control, the traditional super-twisting second-order sliding mode observer algorithm had a problem that the error of rotor position estimation would change with the speed in the permanent magnet synchronous motor (PMSM). In order to improve the control performance of the motor speed and reduce the error of rotor position estimation, an improved sliding mode observer based on hyperbolic function was proposed, and an online identification scheme of stator resistance was designed. A disturbance voltage observer was designed to estimate the distortion voltage caused by the nonlinearity of the inverter on line. Finally, the hardware-in-the-loop test was carried out to verify the feasibility of the scheme. The test results show that the error of position estimation can be reduced by 7.6%, and the accuracy of velocity estimation can be increased by 5.8%.

-

表 1 PMSM相关参数

Table 1. Related parameters of PMSM

参数 值 参数 值 定子电阻/Ω 2.875 额定转矩/(N•m) 5 定子电感/H 0.008 额定电流/A 4.6 极对数/对 4 开通延迟/μs 0.6~1.8 永磁磁链/Wb 0.175 关断延迟/μs 1.8~3.0 m 0.01 死区时间/μs 3.0 额定速度/(r·min−1) 1500 二极管正向压降/V 2.0~3.2 直流母线电压/V 310 饱和压降/V 1.9~2.8 -

[1] 邓自刚,刘宗鑫,李海涛,等. 磁悬浮列车发展现状与展望[J]. 西南交通大学学报,2022,57(3): 455-474,530. doi: 10.3969/j.issn.0258-2724.20220001DENG Zigang, LIU Zongxin, LI Haitao, et al. Development status and prospect of maglev train[J]. Journal of Southwest Jiaotong University, 2022, 57(3): 455-474,530. doi: 10.3969/j.issn.0258-2724.20220001 [2] 孙友刚,徐俊起,贺祯宇,等. 基于误差交叉耦合的多电磁铁悬浮系统滑模协同控制[J]. 西南交通大学学报,2022,57(3): 558-565. doi: 10.3969/j.issn.0258-2724.20210924SUN Yougang, XU Junqi, HE Zhenyu, et al. Sliding mode cooperative control of multi-electromagnet suspension system based on error cross coupling[J]. Journal of Southwest Jiaotong University, 2022, 57(3): 558-565. doi: 10.3969/j.issn.0258-2724.20210924 [3] 尚喆,赵荣祥,窦汝振. 基于自适应滑模观测器的永磁同步电机无位置传感器控制研究[J]. 中国电机工程学报,2007,3: 23-27. doi: 10.3321/j.issn:0258-8013.2007.26.005SHANG Zhe, ZHAO Rongxiang, DOU Ruzhen. Research on sensorless control of PMSM based on adaptive sliding mode observer[J]. Proceedings of the CSEE, 2007, 3: 23-27. doi: 10.3321/j.issn:0258-8013.2007.26.005 [4] 王高林,张国强,贵献国,等. 永磁同步电机无位置传感器混合控制策略[J]. 中国电机工程报,2012,32(24): 103-109.WANG Gaolin, ZHANG Guoqiang, GUI Xianguo, et al. Hybrid sensorless control strategy for permanent magnet synchronous motors[J]. Proceedings of the CSEE, 2012, 32(24): 103-109. [5] XIE G, LU K Y, DWIVEDI S K, et al. Minimum-voltage vector injection method for sensorless control of PMSM for low-speed operations[J]. IEEE Transactions on Power Electronics, 2016, 31(2): 1785-1794. doi: 10.1109/TPEL.2015.2426200 [6] 张磊,高春侠. 一种变增益宽速度范围的永磁同步电机无位置传感器控制[J]. 电机与控制学报,2015,19(8): 36-40,46.ZHANG Lei, GAO Chunxia. Research on variable gain wide speed region sensor-less controltheme for permanent magnet synchronous motors[J]. Electrical Machines and Control, 2015, 19(8): 36-40,46. [7] BOUKATTAYA M, GASSARA H. Time-varying nonsingular terminal sliding mode control foruncertain second-order nonlinear systems with prespecified time[J]. International Journal of Adaptive Control and Signal Processing, 2022, 36(8): 2017-2040. doi: 10.1002/acs.3445 [8] CHI S, XU L Y, ZHANG Z. Sliding mode sensorless control of PM synchronous motor for direct-driven washing machines[C]//Conference Record of the 2006 IEEE Industry Applications Conference Forty-First IAS Annual Meeting. Tampa: IEEE, 2006: 873-879. [9] WANG H M, GE X L, LIU Y C. Second-order sliding-mode MRAS observer-based sensorless vector control of linear induction motor drives for medium-low speed maglev applications[J]. IEEE Transactions on Industrial Electronics, 2018, 65(12): 9938-9952. doi: 10.1109/TIE.2018.2818664 [10] LIANG D L, LI J, QU R H. Sensorless control of permanent magnet synchronous machine based on second-order sliding-mode observer with online resistance estimation[J]. IEEE Transactions on Industry Applications, 2017, 53(4): 3672-3682. doi: 10.1109/TIA.2017.2690218 [11] YI S C, ZHAI J Y. Adaptive second-order fast nonsingular terminal sliding mode control for robotic manipulators[J]. ISA Transactions, 2019, 90: 41-51. doi: 10.1016/j.isatra.2018.12.046 [12] 张勇军,汪伟,张小庆,等. 带电阻在线辨识的改进型永磁同步电机滑模观测方法[J]. 电机与控制学报,2017,21(6): 10-17.ZHANG Yongjun, WANG Wei, ZHANG Xiaoqing, et al. Study on improved sliding-mode control with resistance estimation of PMSM[J]. Electrical Machines and Control, 2017, 21(6): 10-17. [13] LI Z Y, ZHAI J Y, KARIMI H R. Adaptive finite-time super-twisting sliding mode control for robotic manipulators with control backlash[J]. International Journal of Robust and Nonlinear Control, 2021, 31(17): 8537-8550. doi: 10.1002/rnc.5744 [14] KIM H, SON J, LEE J. A high-speed sliding-mode observer for the sensorless speed control of a PMSM[J]. IEEE Transactions on Industrial Electronics, 2011, 58(9): 4069-4077. doi: 10.1109/TIE.2010.2098357 [15] HWANG S H, KIM J M. Dead time compensation method for voltage-fed PWM inverter[J]. IEEE Transactions on Energy Conversion, 2010, 25(1): 1-10. doi: 10.1109/TEC.2009.2031811 -

下载:

下载: