Reinforcement Learning Braking Control of Maglev Trains Based on Self-Learning of Hybrid Braking Features

-

摘要:

精准、平稳停车是磁浮列车自动驾驶制动控制的重要目标. 中低速磁浮列车停站制动过程受到电-液混合制动状态强耦合等影响,基于制动特性机理模型的传统制动控制方法难以保障磁浮列车的停车精度和舒适性. 本文提出一种基于混合制动特征自学习的磁浮列车强化学习制动控制方法. 首先,采用长短期记忆网络建立磁浮列车混合制动特征模型,结合磁浮列车运行环境和状态数据进行动态制动特征自学习;然后,根据动态特征学习结果更新强化学习的奖励函数与学习策略,提出基于深度强化学习的列车制动优化控制方法;最后,采用中低速磁浮列车现场运行数据开展仿真实验. 实验结果表明:本文所提出的制动控制方法较传统方法的舒适性和停车精度分别提高41.18%和22%,证明了本文建模与制动优化控制方法的有效性.

Abstract:Accurate and smooth parking is an essential goal for automatic driving braking control of maglev trains. The strong coupling of the electro-hydraulic hybrid braking state affects the medium and low-speed maglev trains during the stopping braking process, and the traditional braking control method based on the theoretical model of braking features makes it difficult to guarantee the parking accuracy and comfort of the maglev train. This paper proposed a reinforcement learning braking control method for maglev trains based on self-learning of hybrid braking features. First, a long short-term memory (LSTM) network was used to establish a hybrid braking feature model for maglev trains, and the self-learning of dynamic braking features was performed based on the operating environment and status data of maglev trains. Then, the reward function and learning strategy of reinforcement learning were updated according to the learning results of dynamic features, and a train braking optimization control method based on deep reinforcement learning was proposed. Finally, simulation experiments were carried out by using on-site operation data of medium and low-speed maglev trains. The experimental results show that the braking control method proposed in this paper improves comfort and parking accuracy by 41.18% and 22%, respectively, compared with the traditional method. It proves the effectiveness of the modeling and braking optimization control method in this paper.

-

中低速磁浮作为现有城市轨道交通的有益补充,具有安全低碳、静音舒适等优点,在我国具有广阔的应用前景[1]. 制动控制系统是磁浮列车自动驾驶系统(ATO)的重要子系统,在保障列车运行安全、停车精度和舒适性方面起到关键作用[2]. 为有效调节列车速度,中低速磁浮列车主要采用电-液混合制动实现正常到站停车. 由于电制动与液压制动转换过程状态强耦合、液压制动力强非线性等特点,传统的列车制动控制方法难以保障中低速磁浮列车的停车精度和舒适性. 因此,研究中低速磁浮列车电-液混合制动动态特性、混合制动优化控制方法,对提升磁浮列车停站精度和舒适性具有重要意义.

目前,针对传统列车制动过程的研究主要关注制动特性建模和控制算法方面. 精确的制动模型和良好的控制算法是列车平稳、精准停车的重要保障. 李中奇等[3]针对高速动车组动力分散特点建立多质点制动模型,基于径向基神经网络的比例-积分-微分(PID)控制策略与Smith预估器结合对给定速度跟踪控制,满足高速动车组制动过程精准停车要求. 周嘉俊等[4]分析列车实际减速度的影响因素,提出改进史密斯预估器对减速度进行预估控制,提高列车减速度的跟踪精度. 但该方法未识别造成列车减速度偏差原因,只针对跟踪误差对制动力进行调节的方式容易造成实际减速度的震荡,列车平稳性有待提升. 马天和等[5]采用参数估计算法对城轨列车制动过程受到的扰动进行估计补偿,通过在线修正目标制动力实现列车制动力闭环控制. 崔俊锋等[6]针对中低速磁浮列车制动力时滞问题,提出一种时滞补偿的广义预测控制器,有效降低列车制动过程时滞特性影响,提高控制精度. 传统基于物理参数建模方法难以准确表征磁浮列车动态特性,模型误差较大导致列车制动效果不佳. 为准确描述列车制动特性,机器学习算法被广泛用于列车数据驱动建模方面研究[7-8]. Yin等[9]针对高速列车制动系统延时问题,构建了一种滞后信息的长短期记忆网络(LSTM)模型,预测精度有很大提升. Liu等[10-11]结合回声状态神经网络建立高速列车状态预测模型,满足高速列车运行中安全、节能、舒适等多目标优化控制.

近年来,强化学习算法凭借其强大行动决策能力和解决不确定环境下控制问题的优势,在电力系统[12]、能源管理[13]、机器人[14]等领域取得了大量应用研究成果. 已有不少学者尝试将强化学习方法用于列车运行优化控制:张淼等[15]凭借优秀司机驾驶经验,设计一种基于策略梯度的强化学习算法,满足地铁变化场景下的能耗和舒适度等多目标需求; 高豪等[16]利用强化学习方法中的动态规划法优化地铁列车站间运行时间分配问题,有效降低列车牵引能耗;蒋灵明等[17]利用多智能体强化学习对大规模货运列车运行计划进行动态调整,有效降低货运列车延误影响; Shang等[18]提出一种带有参考系统的深度强化学习方法,有效提高智能体的学习效率; Liu等[19]提出一种基于深度Q网络(DQN)的重载列车智能控制方法,解决了列车在长陡坡情况下的循环空气制动控制问题.

本文针对中低速磁浮列车自动驾驶混合制动问题,提出一种混合制动特征自学习的深度强化学习(BFS-DQN)磁浮列车制动优化控制方法. 采用LSTM学习混合制动系统的动态特征,结合强化学习方法进行磁浮列车停站制动控制策略优化,并通过仿真实验验证其在中低速磁浮列车制动优化控制中的有效性.

1. 混合制动特征自学习方法

中低速磁浮列车混合制动特征因电液混合制动状态耦合、液压制动非线性而动态变化,目前广泛采用理论、静态制动特征模型,难以在仿真实验中准确反映强化学习的环境对agent (制动控制器)的奖励情况. 在此,采用LSTM学习混合制动的动态特征,以准确描述强化学习的奖励函数关系.

1.1 中低速磁浮列车混合制动原理

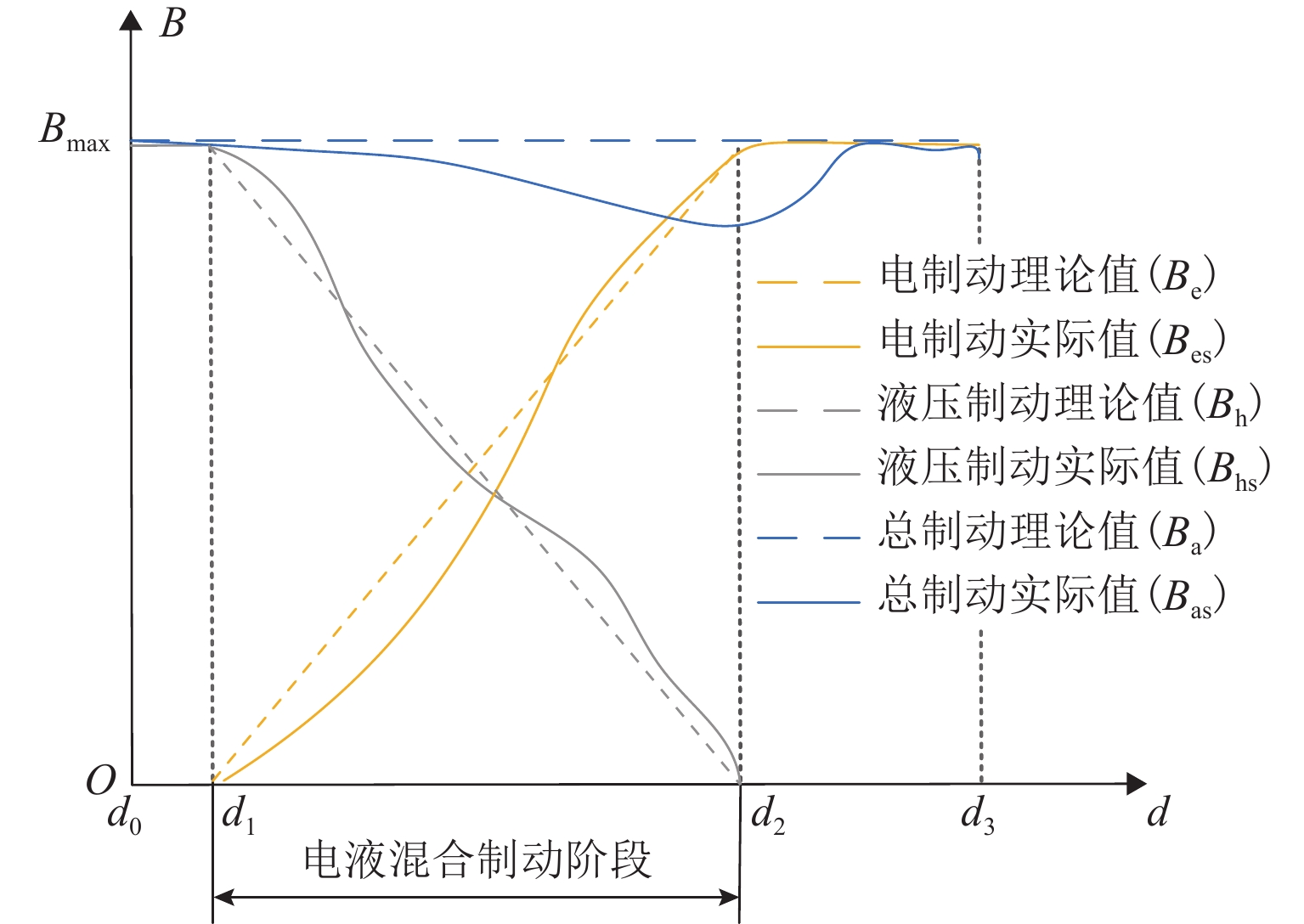

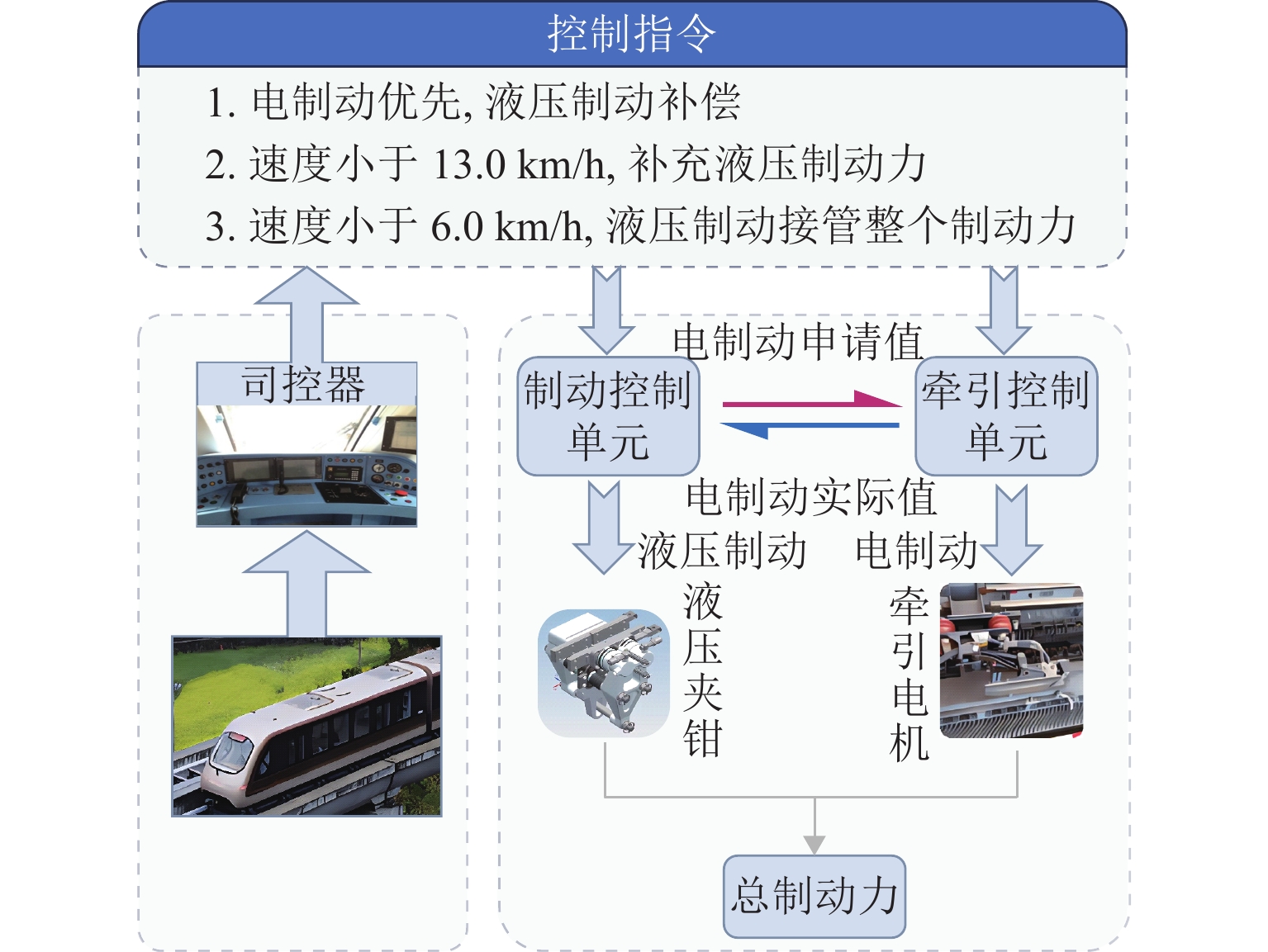

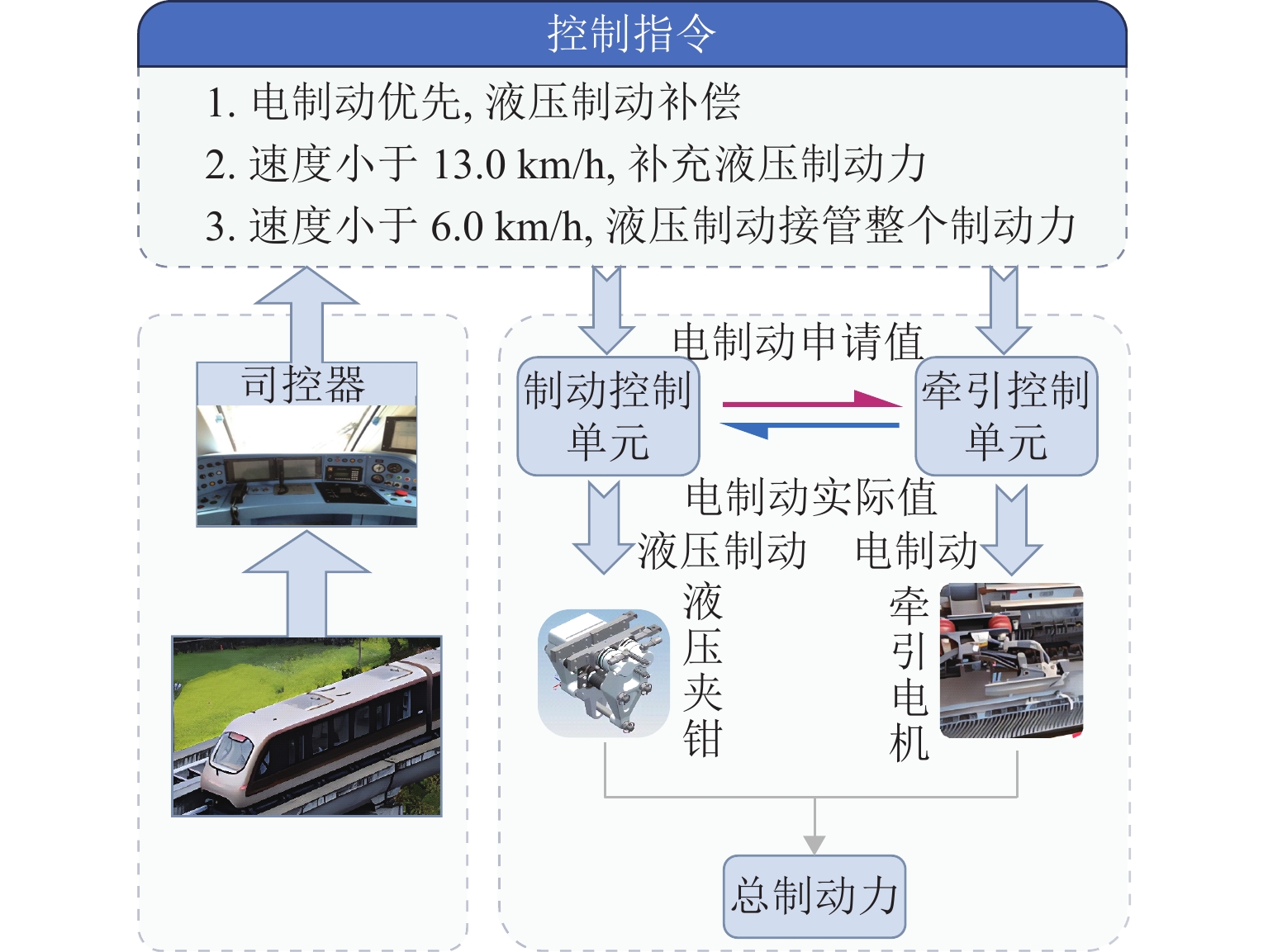

磁浮列车电-液混合制动原理如图1所示.

ATO发出一系列制动指令来操控磁浮列车减速停车. 磁浮列车制动过程遵循电制动优先、液压制动补偿的原则. 列车制动控制单元通过接收制动指令计算全列车所需制动力,按照电制动优先原则,向牵引控制单元发送电制动申请值,并根据反馈的电制动实际值计算所需补充的液压制动力. 然后,制动控制单元通过控制液压夹钳施加液压制动力,实现磁浮列车减速与停车控制.

1.2 混合制动力特征

中低速磁浮列车制动过程除了受到制动力控制外,还受到运行阻力的影响. 中低速磁悬浮列车的运行阻力比轮轨列车更为复杂,运行阻力包括空气阻力、涡流阻力以及附加阻力等.

空气阻力与列车运行速度及车辆编组相关,中低速磁浮列车空气阻力可表示为

Fa=(1.652+0.572N)v2, (1) 式中:N为列车编组数,v为列车速度.

集电器阻力Fc和电磁涡流阻力Fm为

{Fc=96N,Fm={3.354Mv,0<v⩽5.6m/s,(18.220+0.074v)M,v>5.6m/s, (2) 式中:M为列车质量.

附加阻力主要包括坡道阻力Fi和曲线阻力Fr,如式(3).

{Fi=Mgsin(arctanβ),Fr=600RMg, (3) 式中:β为坡度值,R为曲线半径.

由于中低速磁浮列车电-液混合制动力实际值未知,本文将列车制动力特性用函数g(x)表示. 根据中低速磁浮列车制动特性和运行阻力,建立基于牛顿方程的单质点列车制动模型,如式(4).

{v=dsdt,a=dvdt,Ma=g(Fb,Fw)+ξ(t),Fw=Fa+Fc+Fm+Fr+Fi, (4) 式中:s和a为列车位置和加速度,Fb为列车制动力,Fw为列车运行阻力,ξ(t) 为未建模动态,t为时间.

1.3 混合制动动态特征自学习方法

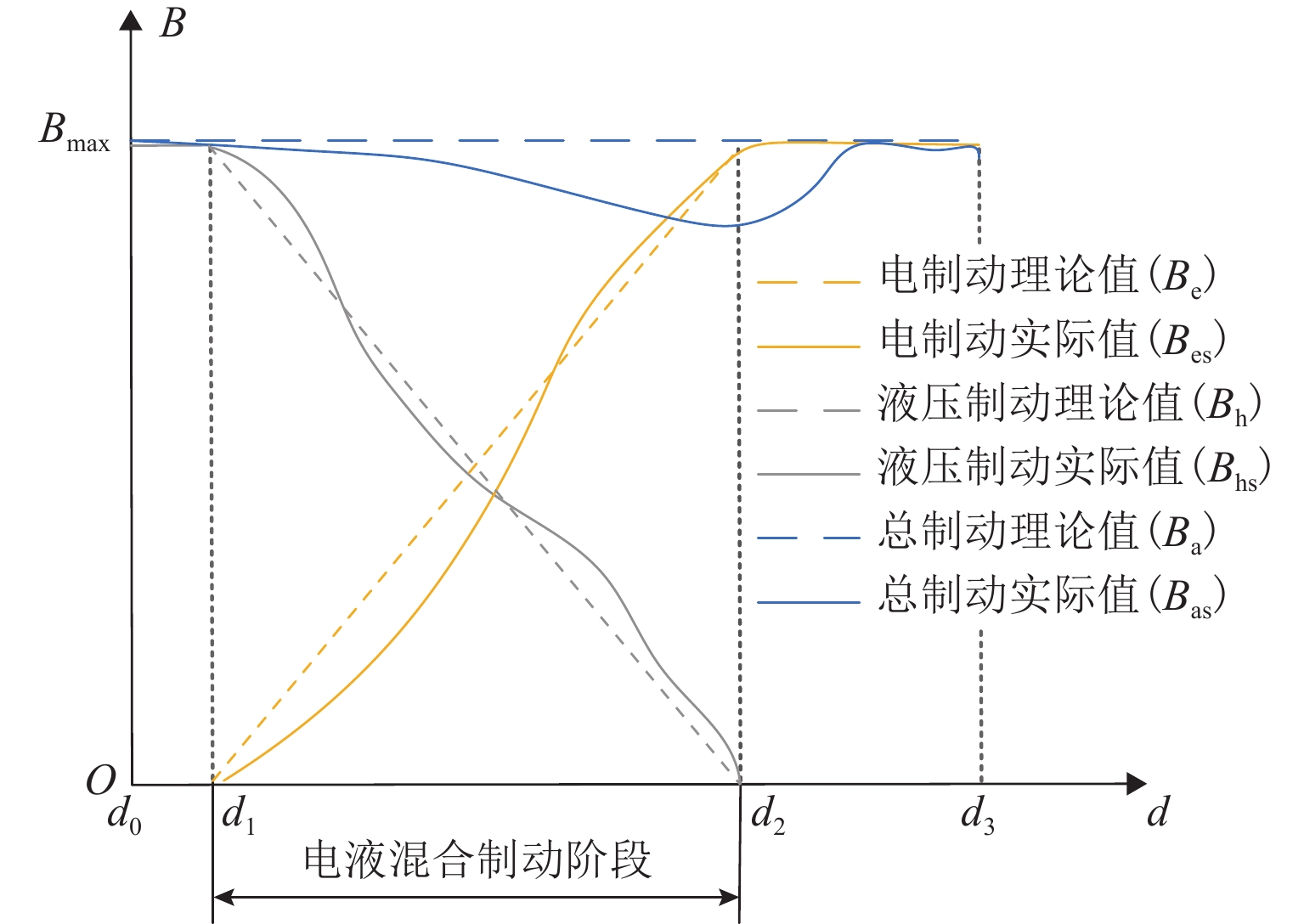

中低速磁浮列车制动过程电制动、液压制动及总制动力变化特性如图2所示,图中:Bmax为最大理论制动力,d为制动距离,B为制动力. 设列车制动系统控制单元发出制动指令时列车制动距离为d0,由于电制动力响应存在短暂延时τ,列车空走一段时间后距离为d1. 此时,电制动力开始减小,液压制动开始补充;制动距离为d2,电制动撤离,液压制动接管整车制动;当制动距离为d3时,液压制动力达到最大值,列车准备停车.

磁浮列车制动特性受到电制动响应延迟、液压制动离散及运行阻力变化等因素影响,列车实际制动力Bs与理论制动力Bn存在较大差距,影响列车到站的停车精度. 同时,电制动和液压制动两者强非线性耦合特点导致磁浮列车电-液混合制动过渡不平稳,容易产生较大纵向冲击,对乘坐舒适性造成影响.

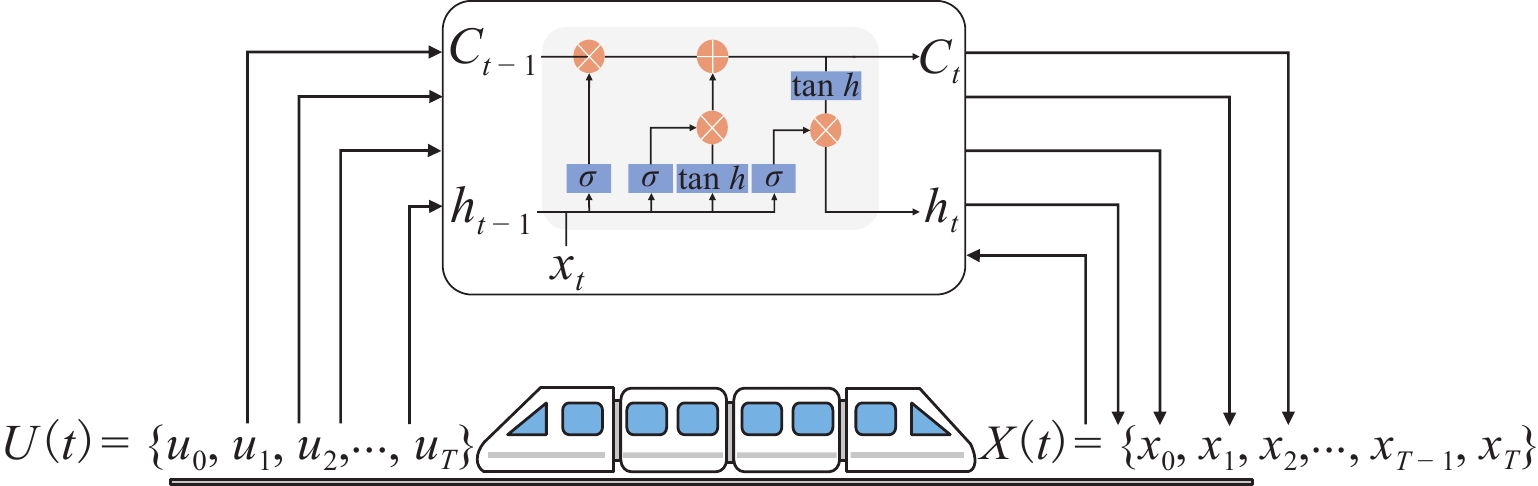

传统的机理模型难以准确描述中低速磁浮列车运行动态,无法保障列车制动效果. LSTM在处理各种非线性时序问题具有良好的效果,本文采用LSTM网络建立磁浮列车数据驱动的制动模型,利用列车历史制动数据进行制动特征自学习,以更准确地描述列车动态特性和预测列车运行状态. 基于LSTM的磁浮列车动态模型为

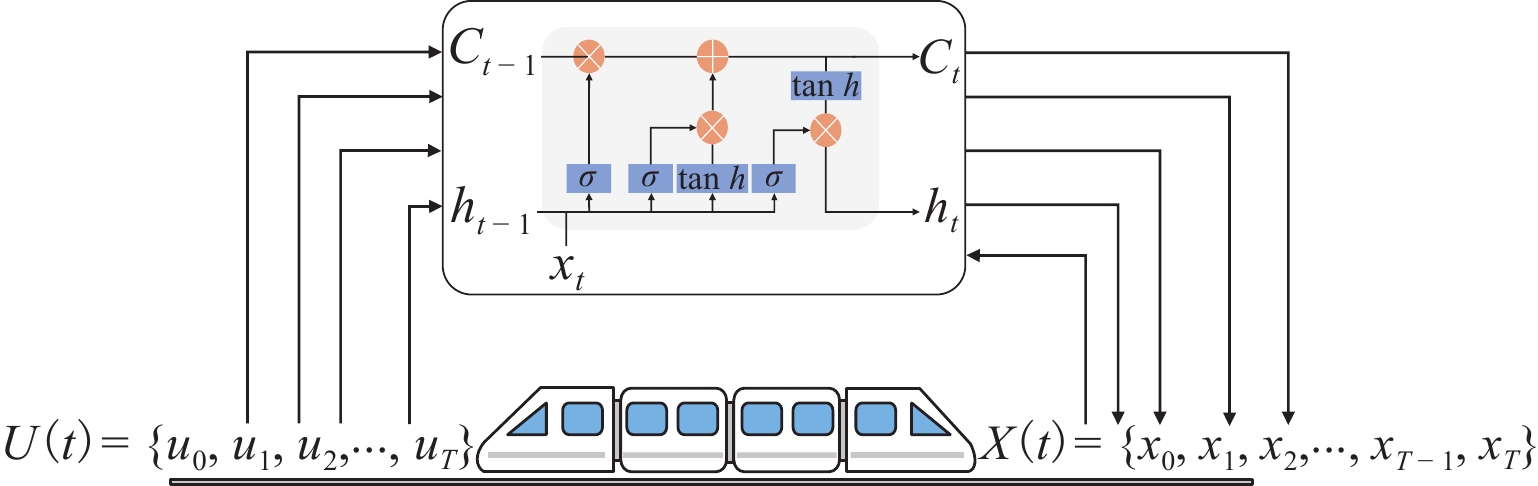

{xt+1=gLSTM(X(t),U(t),w)+ξ(t),X(t)={x1,x2,⋅⋅⋅,xT},U(t)={u0,u1,⋅⋅⋅,uT}, (5) 式中:gLSTM(·)为基于磁浮列车动态模型网络;xt+1={dt+1,vt+1},为列车下一时刻预测状态,即列车位置和速度;U(t)为列车前T时刻一系列的制动指令;X(t)为列车前T时刻的运行状态;w={w1,w2,⋅⋅⋅,wn},为网络训练参数.

为了减小预测输出值与实际值之间的差距,采用均方根误差(RMSE)方法建立损失函数l(θ)且使其最小化,如式(6).

minθl(θ)=(1NT∑t=1(xt−ˆxt)2)12, (6) 式中:xt和ˆxt分别为列车时刻t的实际状态值和预测值.

本文建立基于LSTM网络的磁浮列车动态模型的目的是准确预测列车未来状态,如图3所示. 图中:Ct为时刻t时LSTM单元状态,ht为时刻t时LSTM的输出值. 制动指令u0和列车初始状态{d0,v0}作为已知输入,选取磁浮列车历史制动数据中一系列制动指令{u0,u1,⋅⋅⋅,uT}对模型进行训练,模型可以输出一系列观测到的状态{d1,v1,⋅⋅⋅,dT,vT},最后将预测状态与磁浮列车现场采集的制动数据比较,验证模型准确性.

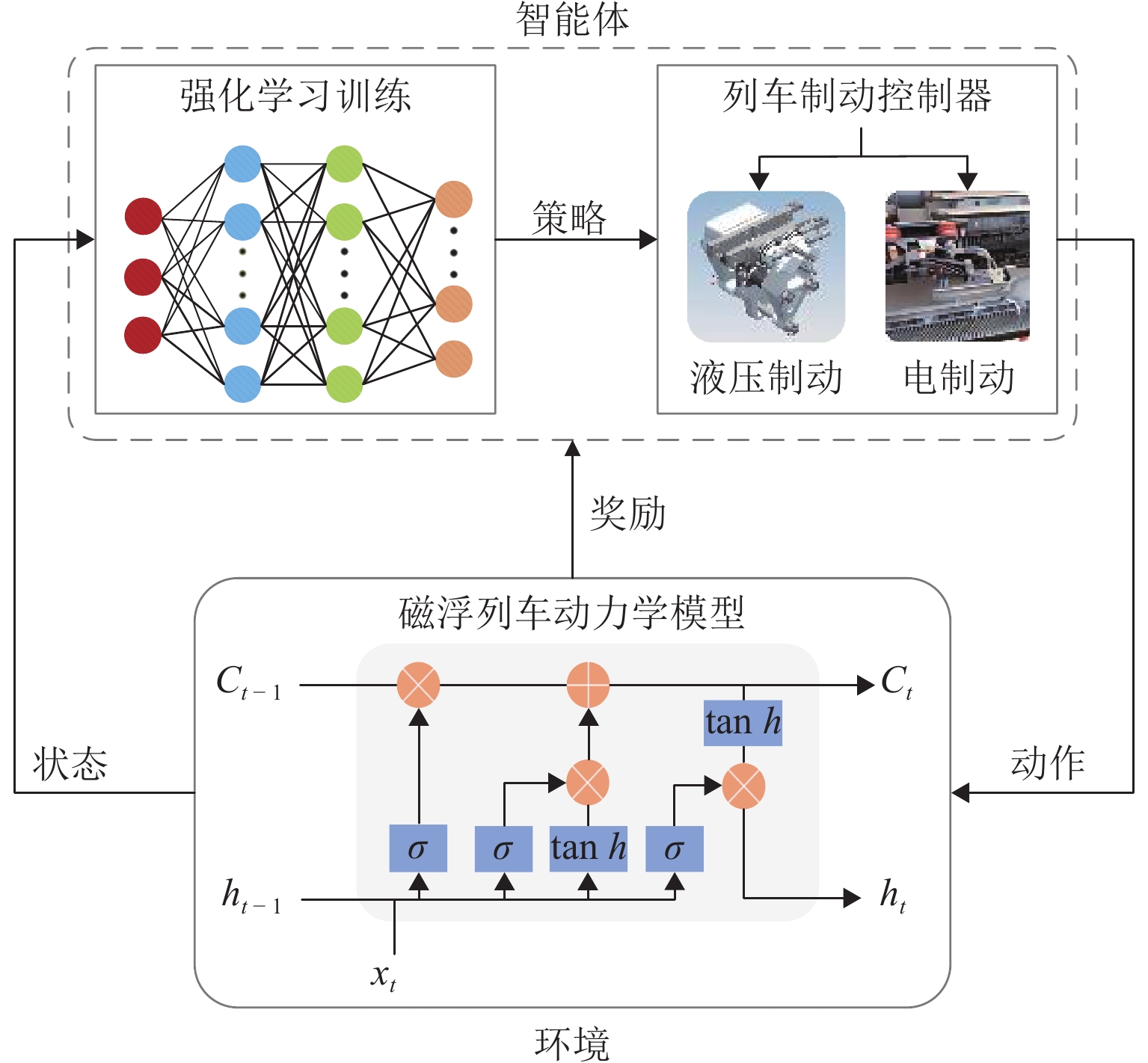

2. 磁浮列车BFS-DQN制动控制方法

深度强化学习算法融合了深度学习和强化学习各自优势,具有优秀的状态感知能力和强化的决策能力[20]. 本文主要关注提出一种BFS-DQN磁浮列车制动控制方法,通过学习磁浮列车制动特性以便准确获取运行状态和计算优化目标,提高端到端的强化学习控制效果.

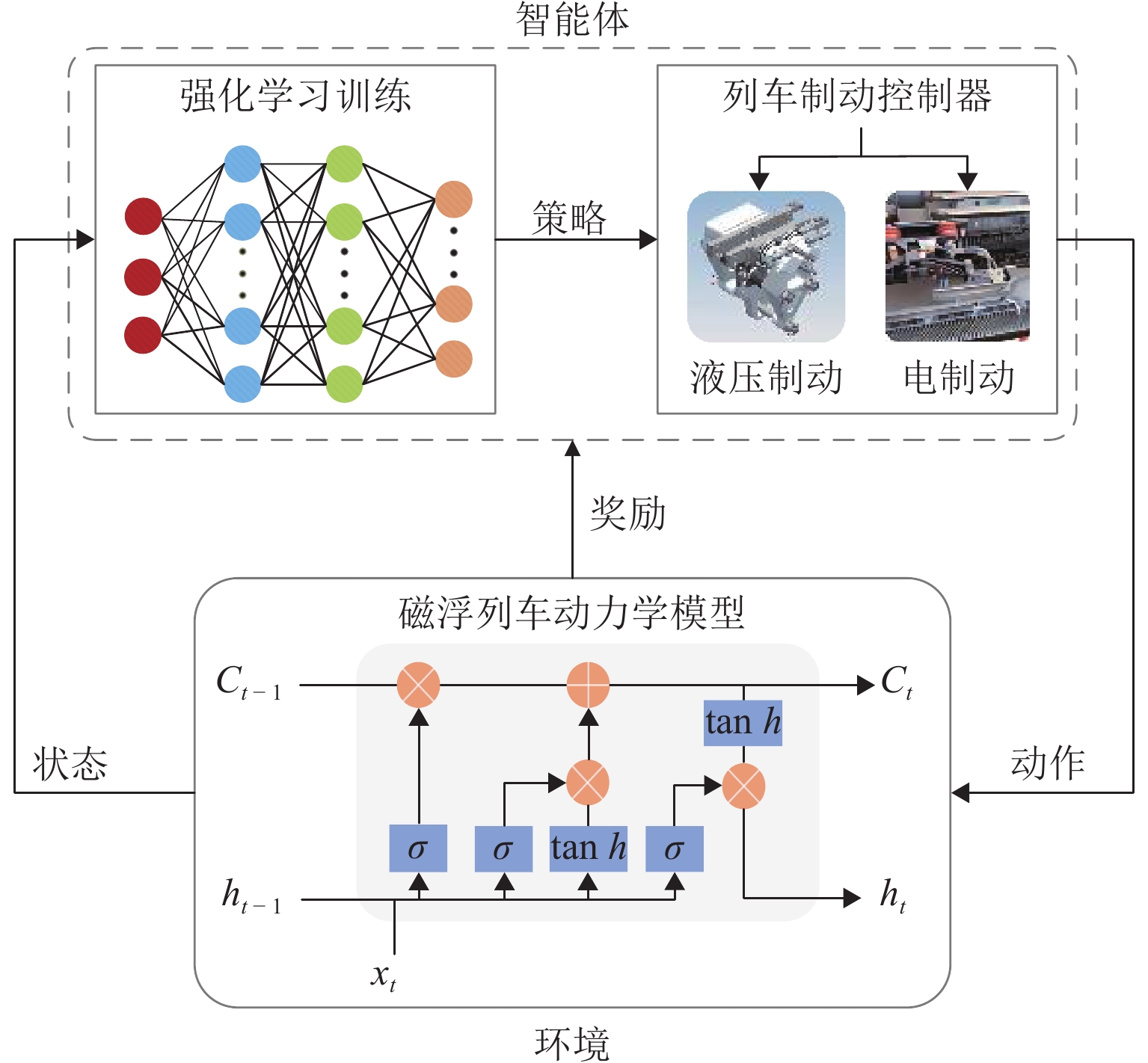

本文提出的BFS-DQN控制方法如图4所示. 首先,通过列车历史运行数据训练LSTM网络,学习列车制动特性与动态环境的关系; 然后,将观测到的列车运行状态作为强化学习算法的输入,列车制动等级作为智能体的动作输出,同时设计舒适性和精准停车奖励函数,通过与环境交互的方式训练列车控制器学习最优控制策略;最后,输出合理的制动力以实现磁浮列车制动优化控制.

2.1 状态空间

根据式(4)、(5),将预测到的列车运行状态,即列车位置d、速度v和加速度a组成的三维状态空间作为强化学习智能体的观测状态,该状态空间S定义为

\begin{split} & S = \{ {\boldsymbol{s}} = {[d\;\;v\;\;a]^{\rm{T}}},\quad d \in [0,{d_{\mathrm{s}}}],v \in [0,{V_0}], \\ &\quad a \in [ - {A_{\max }},0]\}, \end{split} (7) 式中:{d_{\mathrm{s}}}为列车目标停车位置,{V_0}为列车电-液制动转换起始速度,{A_{\max }}为列车最大减速度.

2.2 动作空间

磁浮列车制动过程中,ATO或司机根据运行状况操纵制动等级来调节列车制动力的大小,同样,本文选择列车制动等级作为智能体的动作,动作空间A定义为

{\boldsymbol{A}} = [{u_i}],\quad{u_i} \in [0,100{\text{%}} ], (8) 式中:{u_i}为磁浮列车电-液混合制动等级,0%表示惰行,100%表示施加最大制动力.

2.3 奖励机制

BFS-DQN中,智能体通过每个时间步采取最佳行动来获得更多的奖励回报,可靠的奖励机制对于引导智能体学习最佳行动策略具有重要作用. 因此,本文根据磁浮列车制动优化控制目标,设计关于舒适性和精准停车的奖励函数,最后通过加权求和的方式得到总奖励,该奖励函数定义为

\left\{ \begin{array}{l} {r_{{\rm{total}}}} = {\lambda _1}{r_{{\rm{comfort}}}} + {\lambda _2}{r_{{\rm{stop}}}} + {r_{{\rm{fail}}}}, \\ {r_{{\rm{comfort}}}} = 1 - a_{{\rm{error}}}^2,\quad {a_{{\rm{error}}}} \leqslant 1.0\; {\rm{m/s}}^{3}, \\ {r_{{\rm{stop}}}} = 1 - d_{_{{\rm{error}}}}^2,\quad {d_{{\rm{error}}}} \leqslant 0.3\; {\rm{m}}, \\ {r_{{\rm{fail}}}}, \quad {a_{{\rm{error}}}} \gt 1.0\; {\rm{m/s}}^{3}\;{\mathrm{or}}\; {d_{{\rm{error}}}} \gt 0.3\;{\rm{m}}, \end{array} \right. (9) 式中:{r_{{\rm{total}}}}为列车前后状态转移产生的即时总奖励;{\lambda _1},{\lambda _2}为奖励权重;{r_{{\rm{confort}}}}为乘客舒适性奖励函数;{a_{{\rm{error}}}}为单位时间内减速度的变化激烈程度,用于描述乘客乘车体验[21];{r_{{\rm{stop}}}}为列车精准停车的奖励函数;{d_{{\rm{error}}}}为列车实际制动距离与目标制动距离的差值,用于描述停车精准性;为节省时间成本,设置了惩罚函数{r_{{\rm{fail}}}}对停车失败和减速度剧烈变化的情况给予训练失败惩罚.

2.4 学习策略

本文定义列车控制器作为BFS-DQN中的智能体,采用价值迭代方式学习最优的制动策略. 首先,定义一个价值函数{Q_\pi }(s,u)用于描述智能体从开始到结束时的预期未来总奖励,列车制动控制器采用随机策略\pi 进行动作学习时,从当前时间t\;(t = 0,1, 2,\cdots)观察环境状态{s_t}({s_t} \in S),控制器再从制动级位的集合A中选择一个动作{u_t}. 然后,环境根据列车当前状态信息和制动级位给予一定奖励{r_t}且列车转移到新的状态{s_{t + 1}}. 列车控制器通过评估每个动作的价值,并采取最大价值更新{Q_\pi }({s_t},{u_t}),更新方式为

{Q_\pi }\left( {{s_t},{u_t}} \right) = {r_t} + \gamma \max {Q_\pi }\left( {{s_{t + 1}},{u_{t + 1}}} \right), (10) 式中:γ为目标值的折扣系数.

为了得到最大的奖励回报,假设状态转移概率p已知,根据贝尔曼最优方程和最优性原理求得最优动作策略{\pi ^ * }({s_t}|{u_t}),智能体经过多次价值迭代后其价值函数{Q_\pi }({s_t},{u_t})收敛于最优价值函数 Q_\pi ^ * ({s_t},{u_t}) ,此时,最优价值函数 Q_\pi ^ * ({s_t},{u_t}) 等于最优状态值函数 V_\pi ^ * ({s_t}) ,策略更新如式(10)[22].

V_\pi ^ * ({s_t}) = Q_\pi ^ * ({s_t},{u_t}) = \mathop {\max }\limits_u \left({r_t} + \gamma \sum\limits_{s \in S} p({s_{t + 1}}|{s_t},{u_t}){V^ * }({s_t})\right), (11) 式中: {V^ * }({s_t}) 为时刻t的状态价值函数.

2.5 学习过程

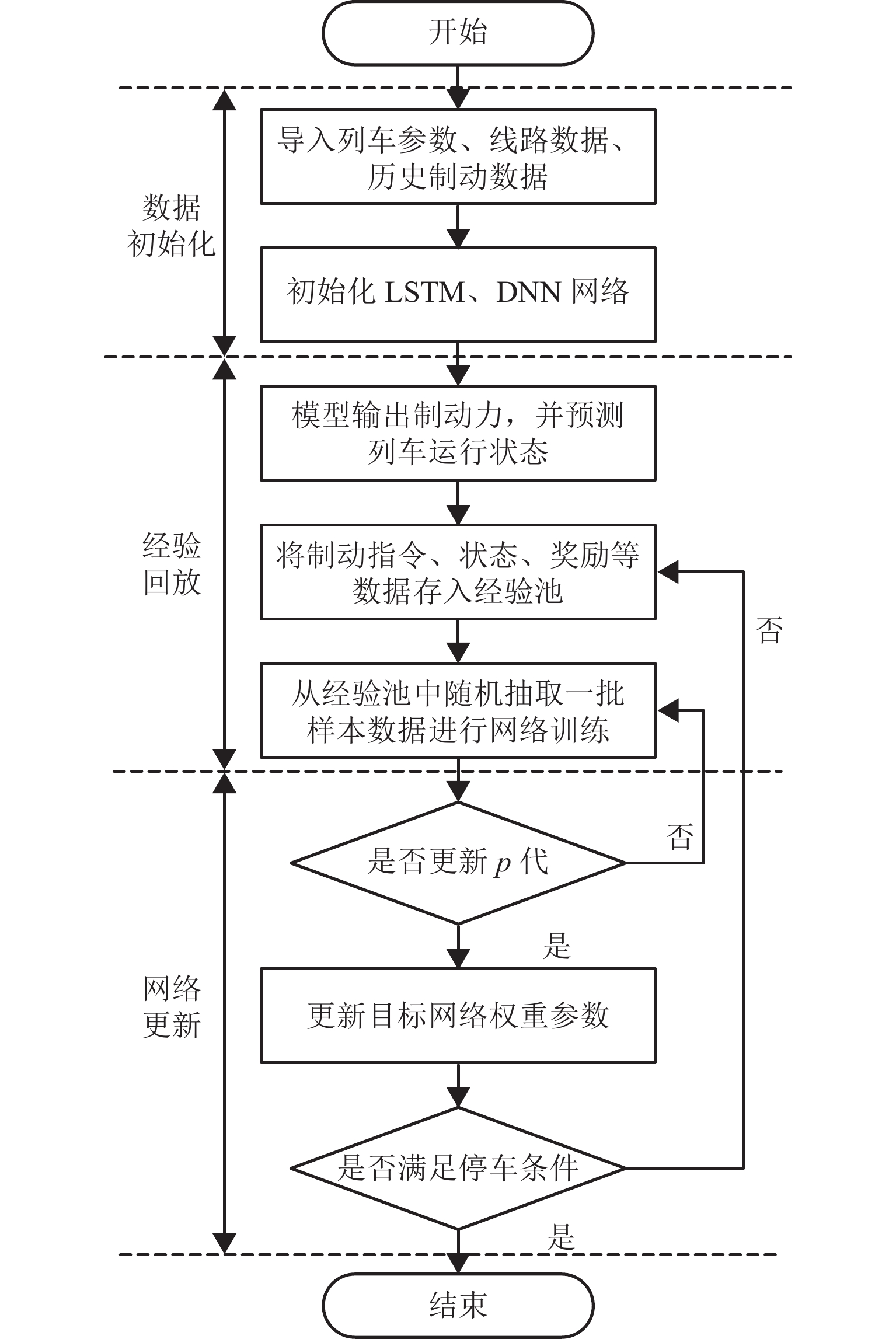

2.5.1 数据生成

列车制动控制器通过观测当前时刻运行状态{s_t},主Q网络对当前状态根据动作选择策略输出对应列车制动等级的动作{u_t},列车状态预测模型根据动作和当前状态生成新的状态{s_{t + 1}};环境根据列车制动过程优化目标设计的奖励函数,计算状态{s_t}转移到新状态{s_{t + 1}}的奖励{r_t}.

2.5.2 经验回放

将时刻t状态、动作和奖励数据 \lt {s_t},{u_t},{r_t},{s_{t + 1}} \gt 存入经验池中,作为列车制动控制器的学习数据. 训练时,随机从经验池中抽取一定数量的样本 \lt {s_j}, {u_j},{r_j},{s_{j + 1}} \gt 作为训练数据,将状态和动作 \lt {s_j},{u_j} \gt 输入到主Q网络得到对应动作的Q({s_j},{u_j};{\theta _j})(\theta_j 为当前神经网络权重系数), \lt {s_{j + 1}},{u_{j + 1}} \gt 输入到目标Q网络中得到目标值\max \tilde Q({s_{j + 1}},{u_{j + 1}};{\theta _{j + 1}})(\theta_{j+1} 为目标网络的权重系数).

2.5.3 网络更新

BFS-DQN中Q网络通过式(12)更新参数权重.

\left\{ \begin{gathered} L({\theta _j}) = {E}[({r_j} + \gamma \mathop {\max }\limits_u \tilde Q({s_{j + 1}},{u_{j + 1}};{\theta _{j + 1}}) - \\ \quad Q^2{({s_j},{u_j};{\theta _j})}], \\ {\theta _{j + 1}} = {\theta _j} + \alpha {\rm{loss}}(\theta )\nabla Q({s_j},{u_j};{\theta _j}), \\ \end{gathered} \right. (12) 式中: \alpha 为网络学习率.

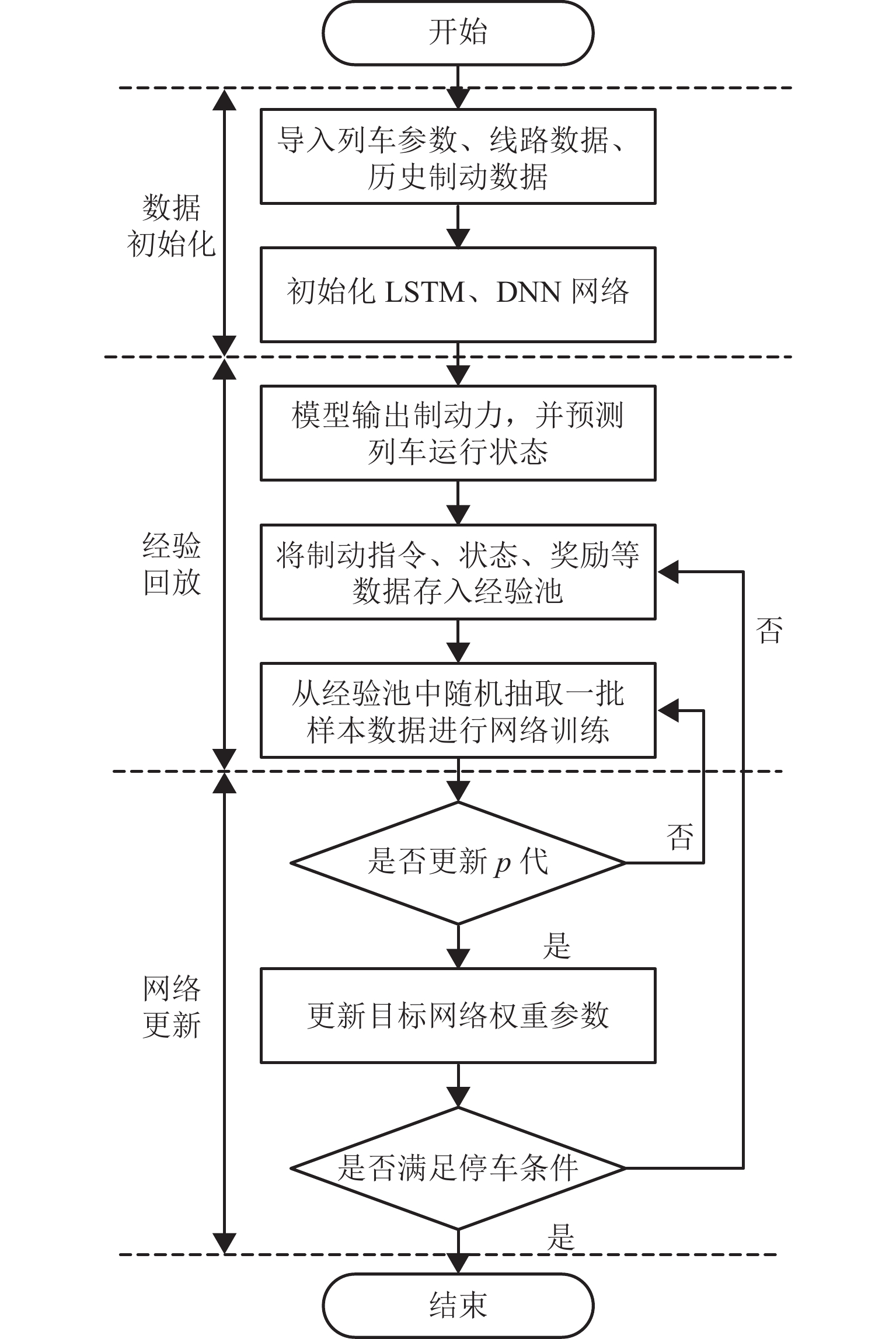

间隔一定训练次数复制主Q网络的权重参数到目标Q网络. 上述过程经过一定次数的循环训练,主Q网络收敛于目标Q网络,列车制动控制器学习到最优制动策略. BFS-DQN训练示意如图5.

3. 实验结果与分析

3.1 实验设置

为验证本文所提BFS-DQN方法有效性,以湖南省某条磁浮线路现场运营数据为例进行仿真验证,列车主要参数详见表1所示.

表 1 仿真列车参数Table 1. Simulation train parameters参数类别 参数特性 列车质量/t 75 线路最高限速/(km·h−1) 80 编组数量 3 最大常用制动力/kN 74.23 最大常用减速度/(m·s−2) 0.96 线路最大坡度/‰ 51.01 3.2 收敛性对比

本文采用传统DQN控制方法与BFS-DQN分别进行仿真,主要训练参数详见表2.

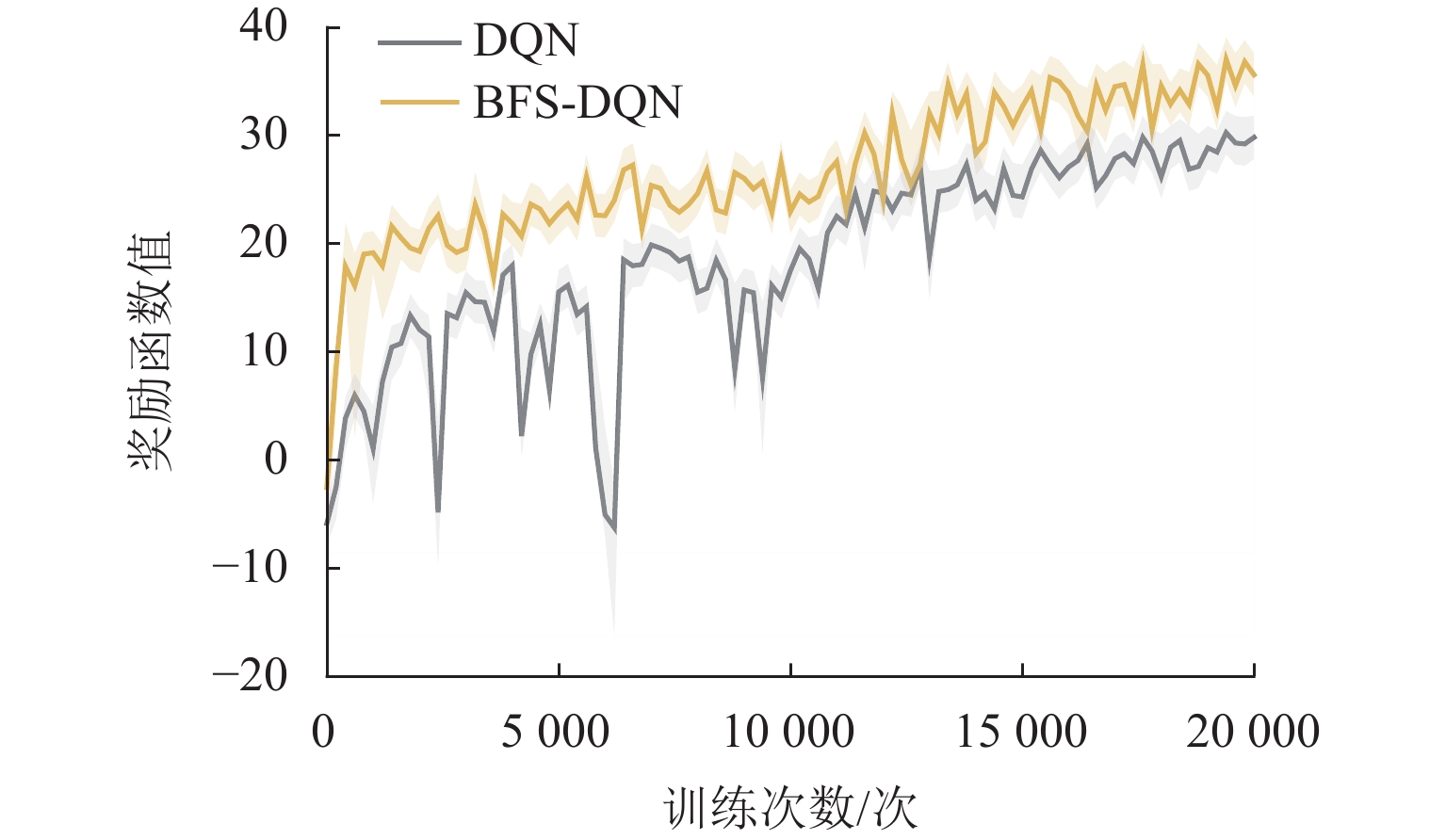

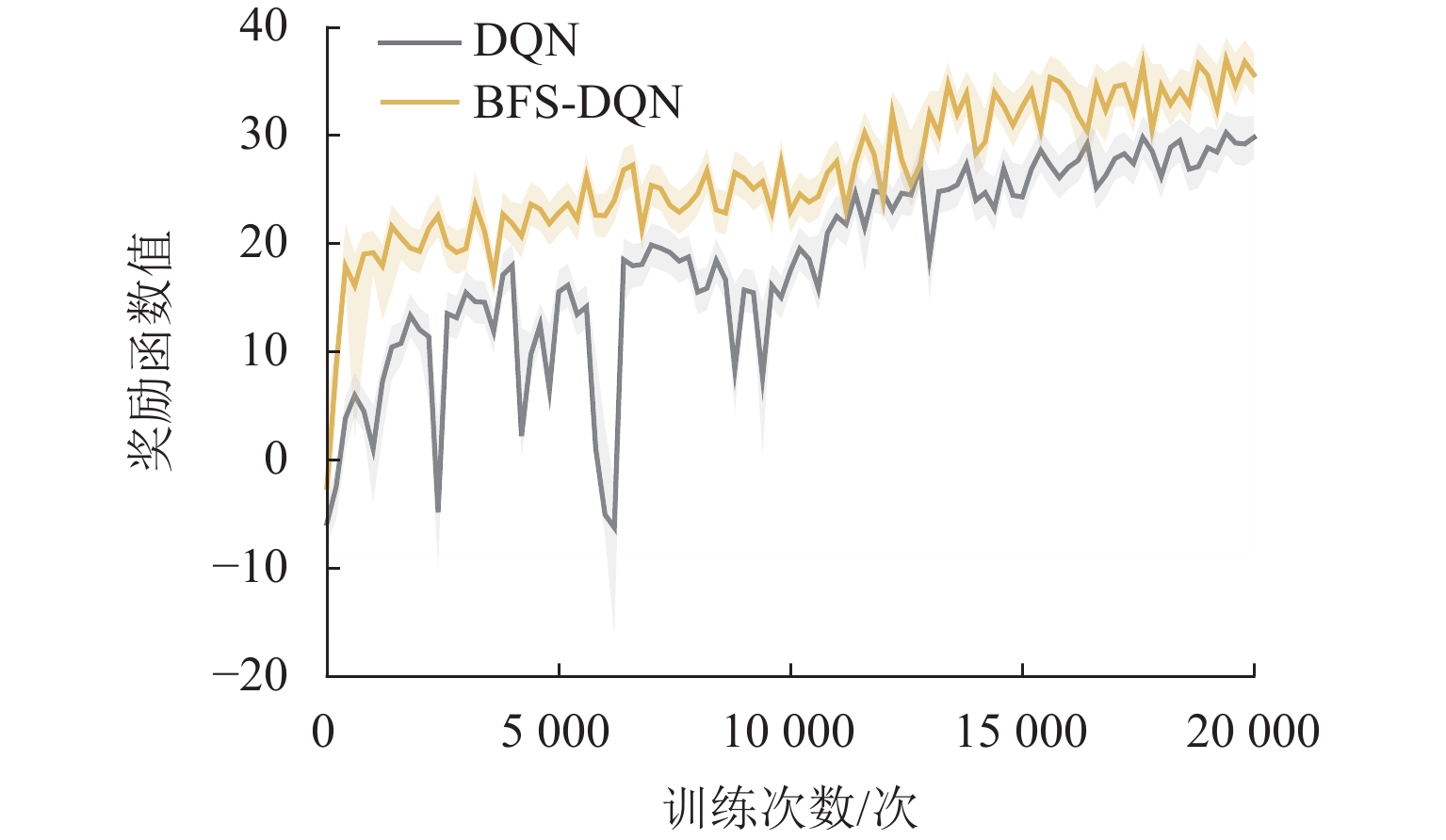

表 2 算法主要训练参数Table 2. Main training parameters for algorithm参数 BFS-DQN DQN LSTM 迭代次数/次 500 LSTM 学习率 0.001 LSTM 样本批量 50 单次训练最大步数/步 80 80 训练最大次数/次 20000 20000 Q 网络学习率 0.001 0.001 Q 网络更新频率 100 100 样本大小 32 32 经验池容量 2000 2000 折扣因子 0.96 0.96 贪婪率初始值 0.9 0.9 贪婪率最终值 0.1 0.1 同时,本文采用动态 {\varepsilon {\text{-}} {\rm{greedy}}} 优化算法使智能体能够合理利用探索策略. 训练初期采用较大探索率,随着训练次数增加,探索率减小,智能体偏向选择奖励值最大的动作. 对列车控制器进行20000次训练,每250轮计算平均奖励值,通过观察奖励函数变化情况来判断算法是否收敛. BFS-DQN和DQN训练过程奖励变化情况详见图6所示.

从图6可以看出:训练初BFS-DQN和DQN的奖励值都呈现出明显上升趋势,说明智能体能够迅速找到合适的动作策略;训练次数达到12000次以上,2种优化算法平均奖励值缓慢上升并趋于稳定;BFS-DQN方法平均奖励高于传统DQN方法,制动特征自学习有助于强化学习智能体获取准确的状态信息和奖励,提高网络学习能力.

3.3 舒适性和停车精度

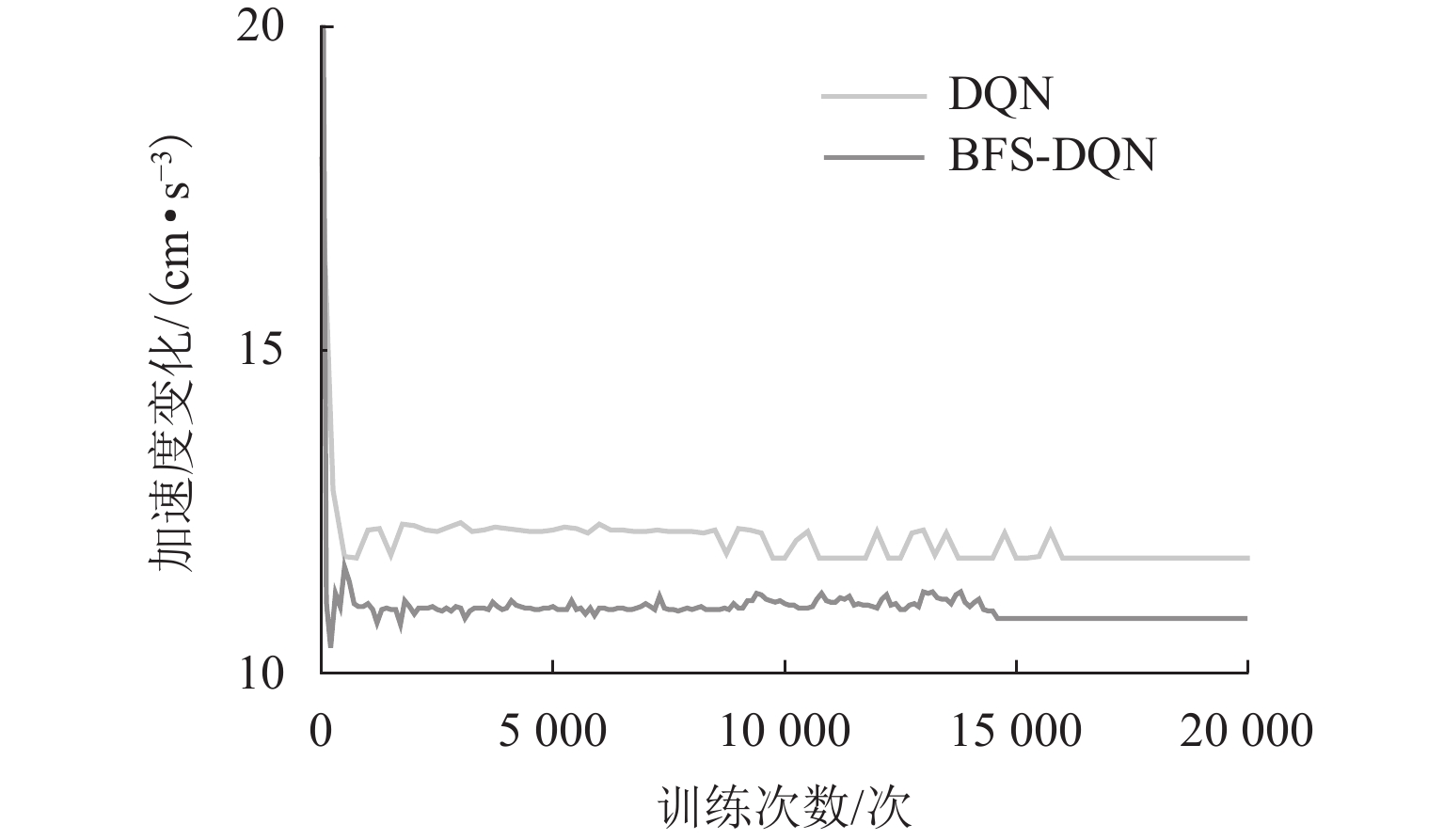

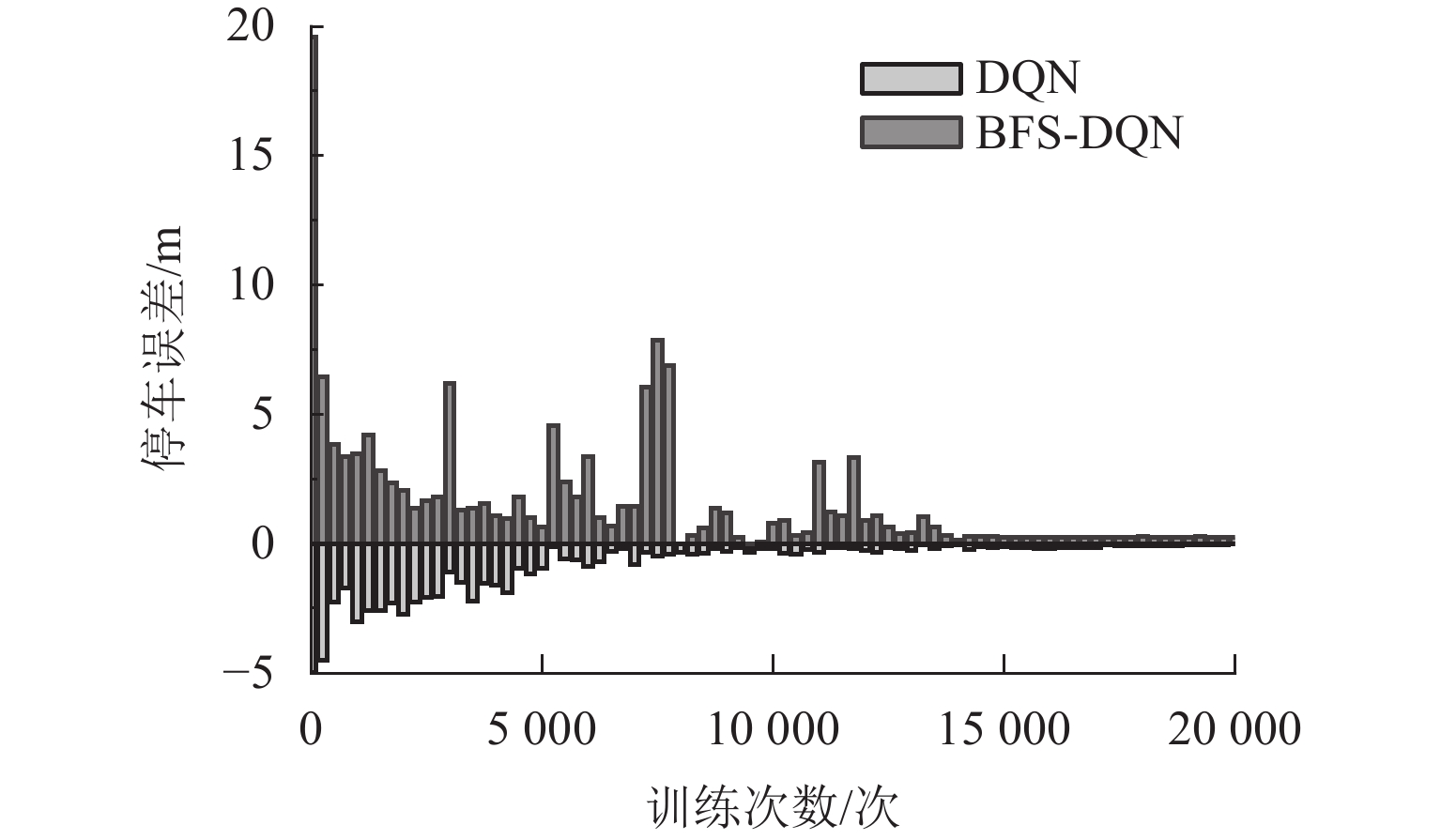

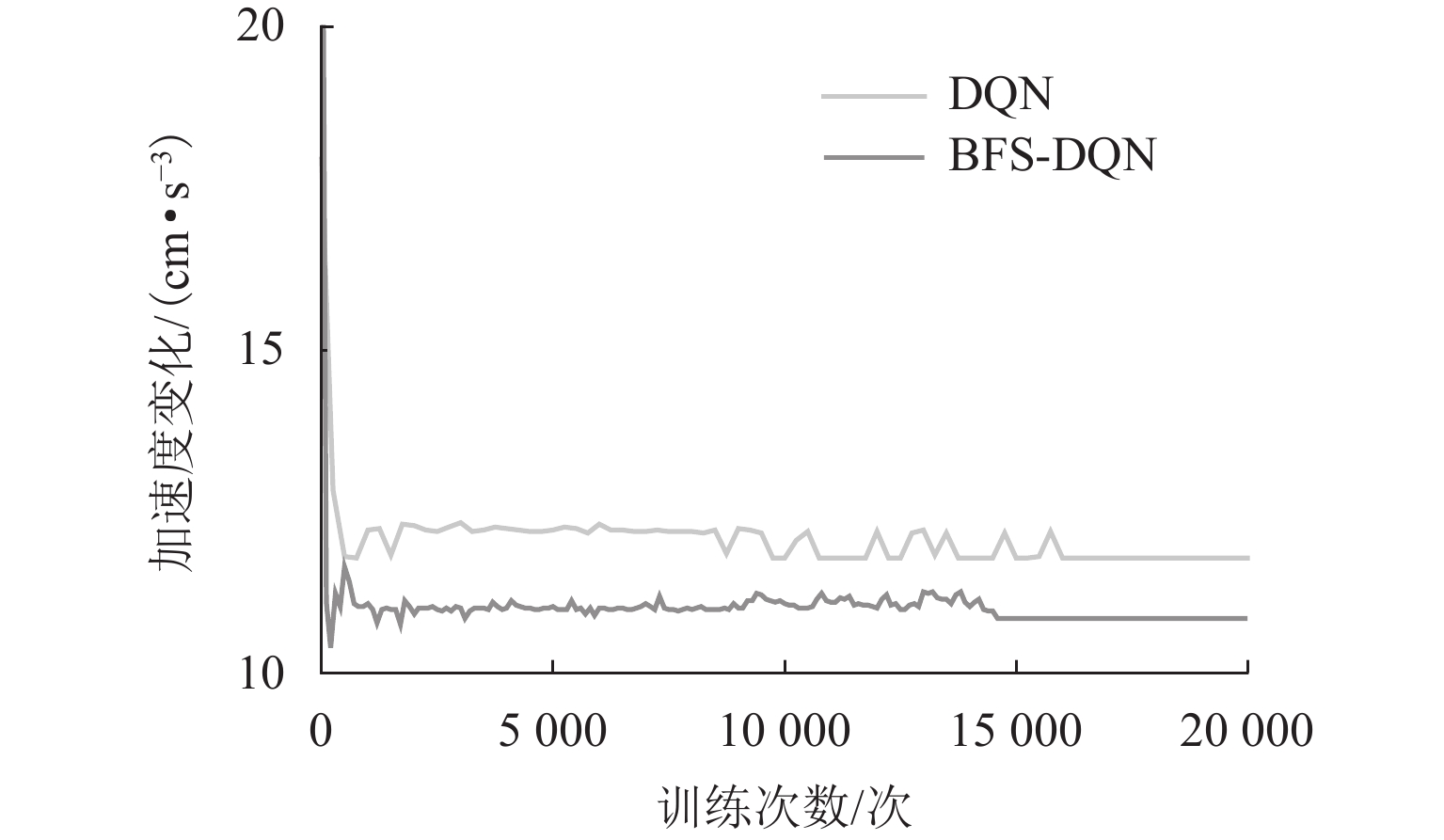

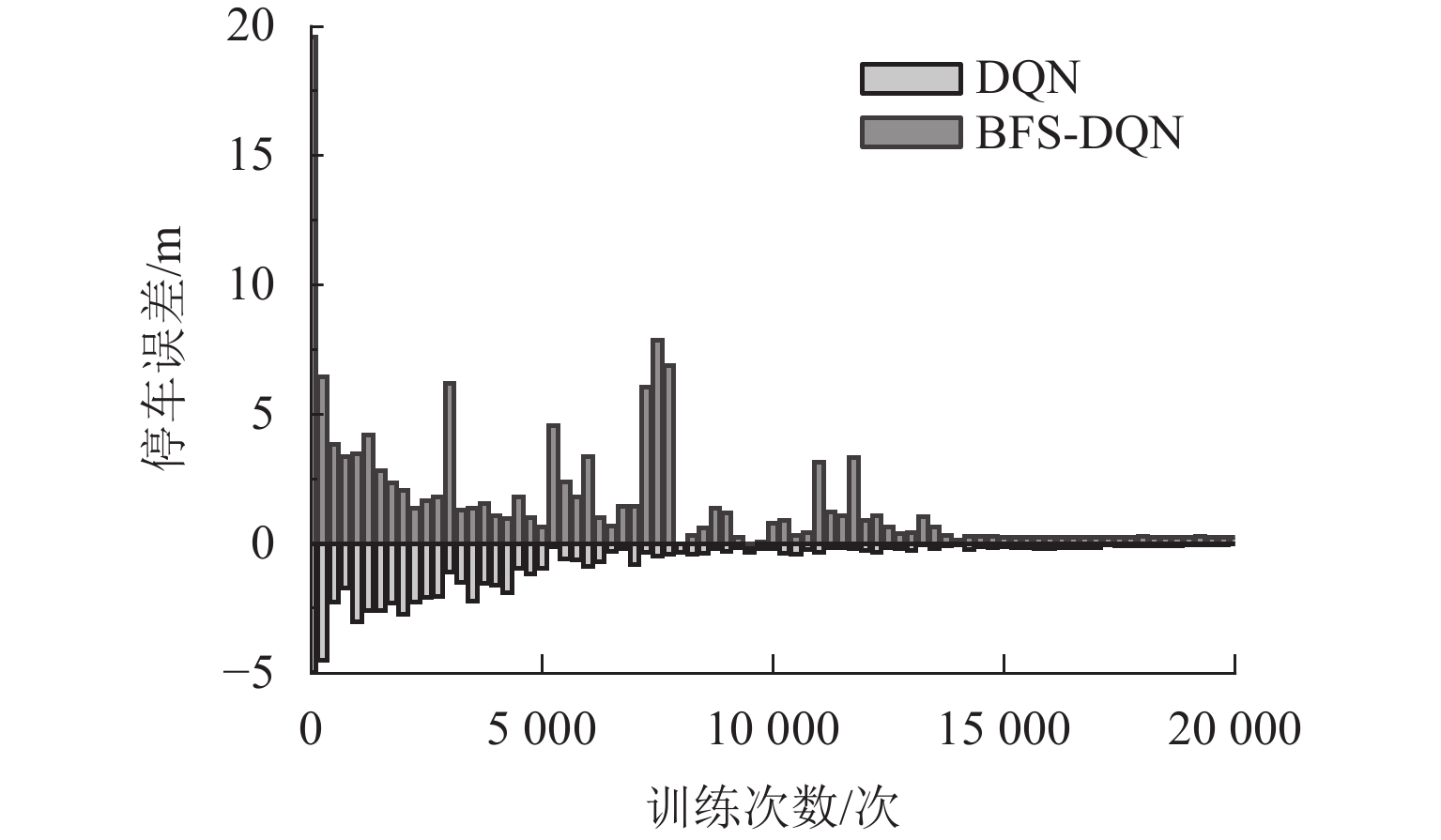

图7和图8分别为训练过程中平均加速度变化和平均停车误差变化情况. 统计最后5000次训练结果,加速度变化和停车误差情况如表3所示.

从图7和图8可以看出:初期加速度变化和停车误差都很大,但加速度变化很快收敛,由于停车奖励需要列车到站才能获得,智能体经过更多次的训练才寻得最优的停车策略. 由表3可得:BFS-DQN在舒适性和停车精度方面比传统DQN提高8.67%和33.33%. 训练结果表明:基于BFS-DQN磁浮列车制动优化控制方法取得了良好的控制效果,且比传统DQN方法在舒适性和停车精度方面更具有优越性.

表 3 算法训练结果Table 3. Training results for algorithm训练结果 BFS-DQN DQN 平均奖励值 33.5 27.8 平均状态转移次数/次 70 72 平均停车误差/m 0.10 0.15 平均加速度变化/(cm·s−3) 10.84 11.78 平均制动时间/s 14.0 14.4 3.4 实际运行数据验证实验

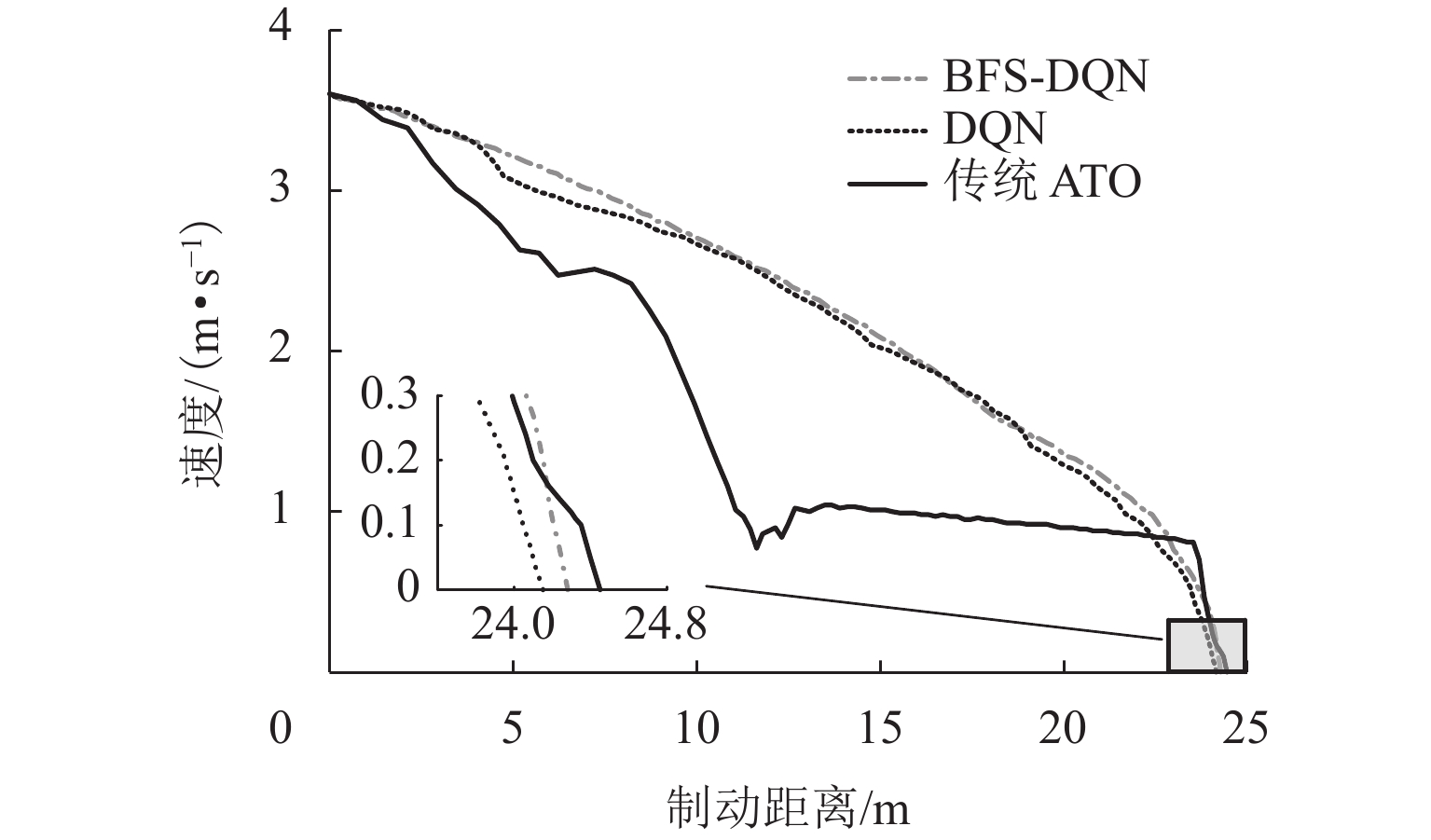

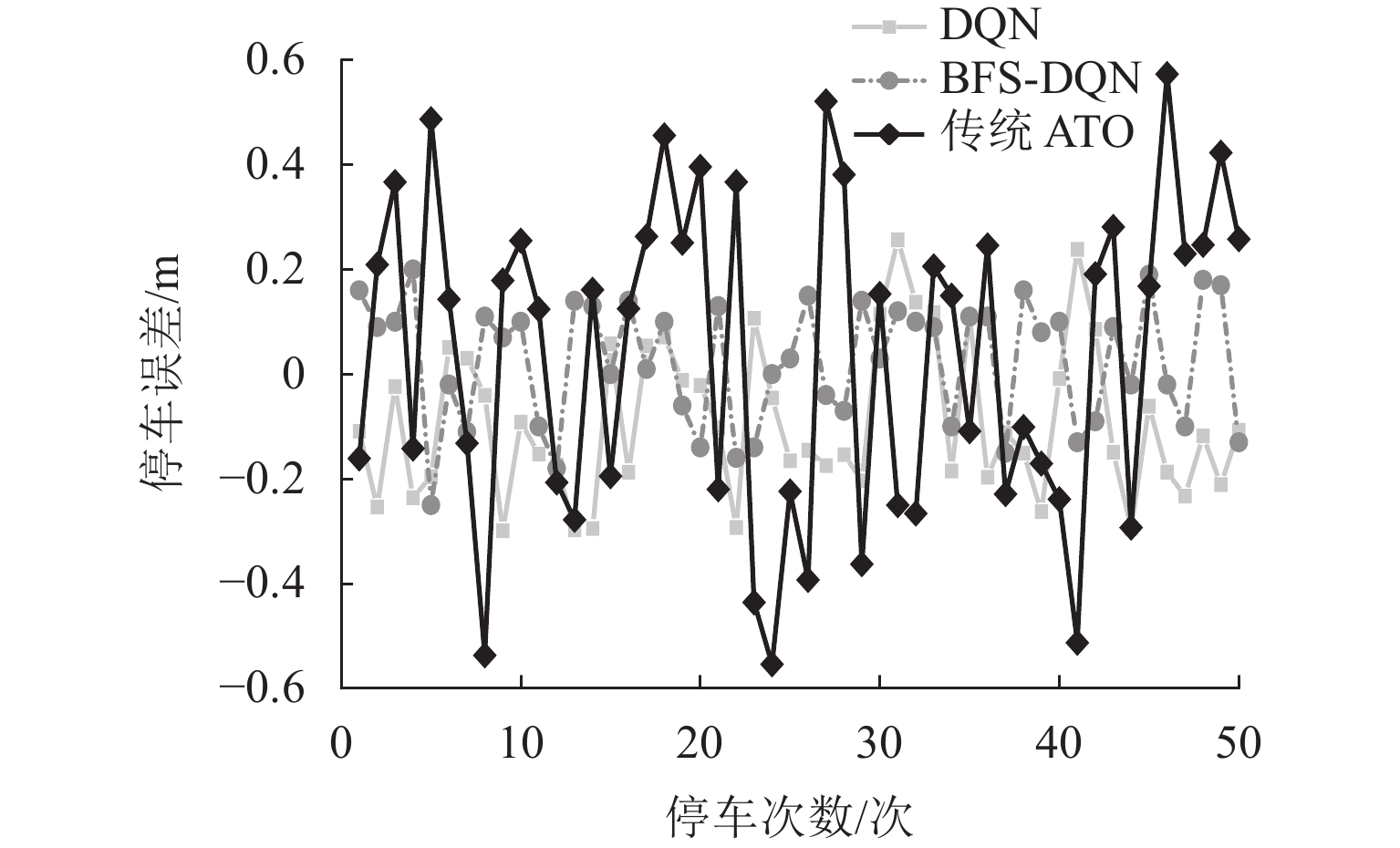

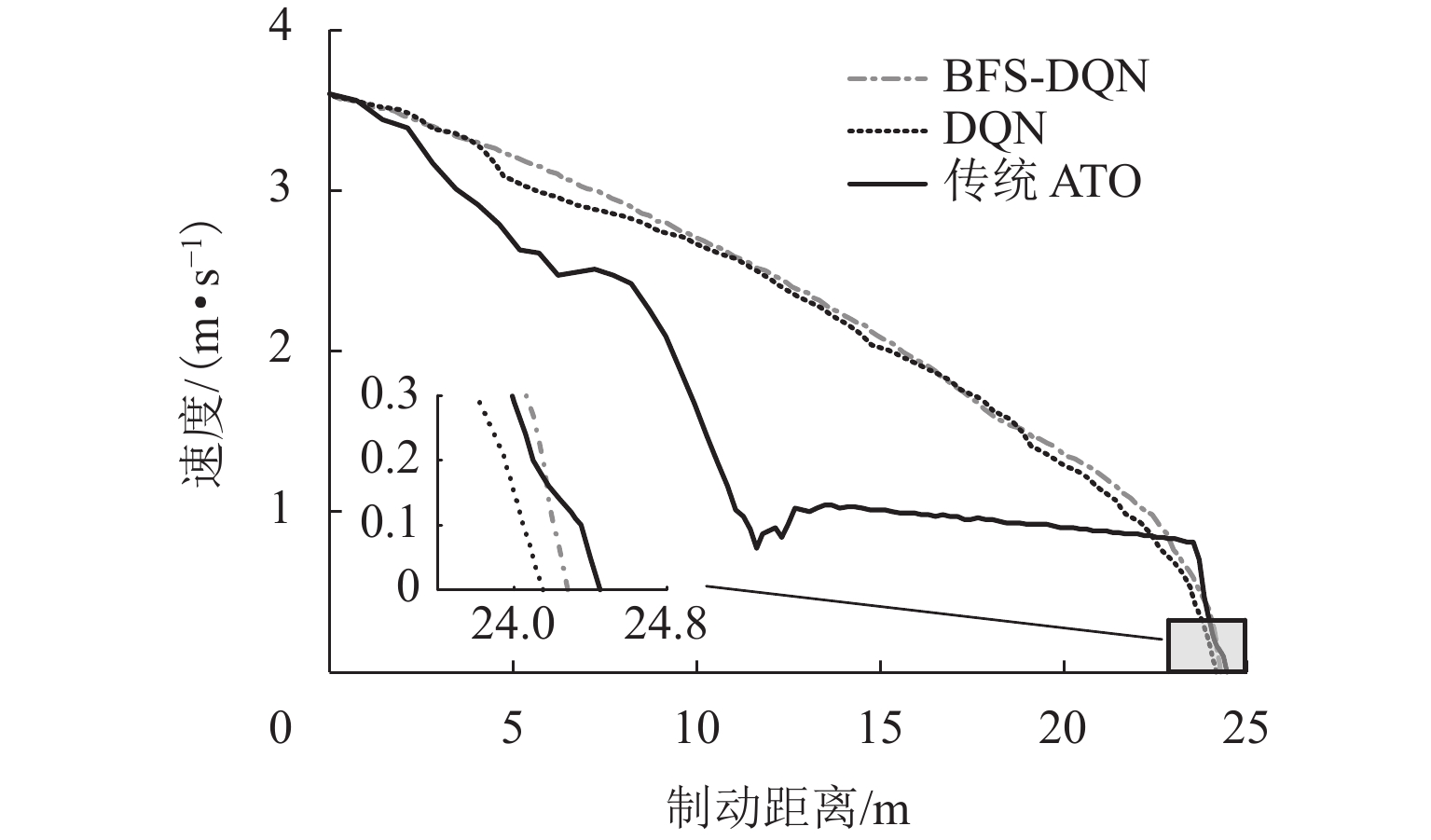

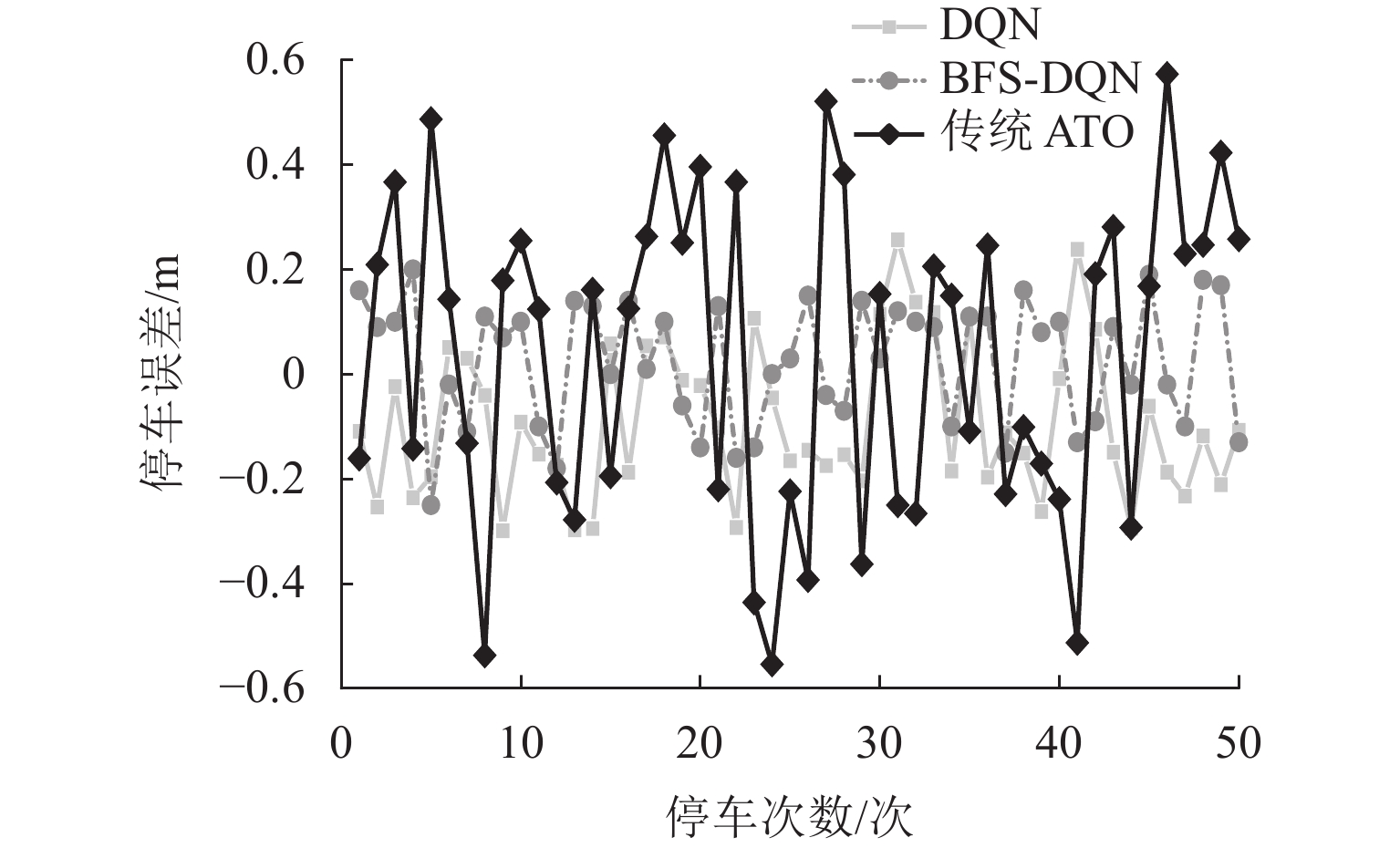

为验证BFS-DQN算法可行性,将训练好的列车控制器进行仿真测试,并记录50次测试的停车误差数据. 同时,本文分别采用均方根误差(RMSE)和标准差(SD)来评价不同制动算法的性能,结果如表4所示. 取其中一次数据的制动曲线如图9所示.

表 4 算法性能Table 4. Algorithm performance制动控制策略 RMSE SD BFS-DQN 0.099048 0.070652 DQN 0.142815 0.110446 传统 ATO 0.276103 0.140018 由表4可见:3种制动控制算法中,BFS-DQN制动控制算法的表现最好,停车误差小,且离散程度低,稳定性高. 由图9可知:采用传统ATO制动策略生成的制动曲线波动较大,而BFS-DQN和DQN制动策略生成的制动曲线较为平滑;停车精度方面,BFS-DQN、DQN和传统ATO 制动策略下的制动距离分别为24.26、24.19、24.45 m,停车误差分别为0.04、0.11、0.15 m,BFS-DQN和DQN方法都能够有效提高磁浮列车到站停车精度,且BFS-DQN方法更具优越性.

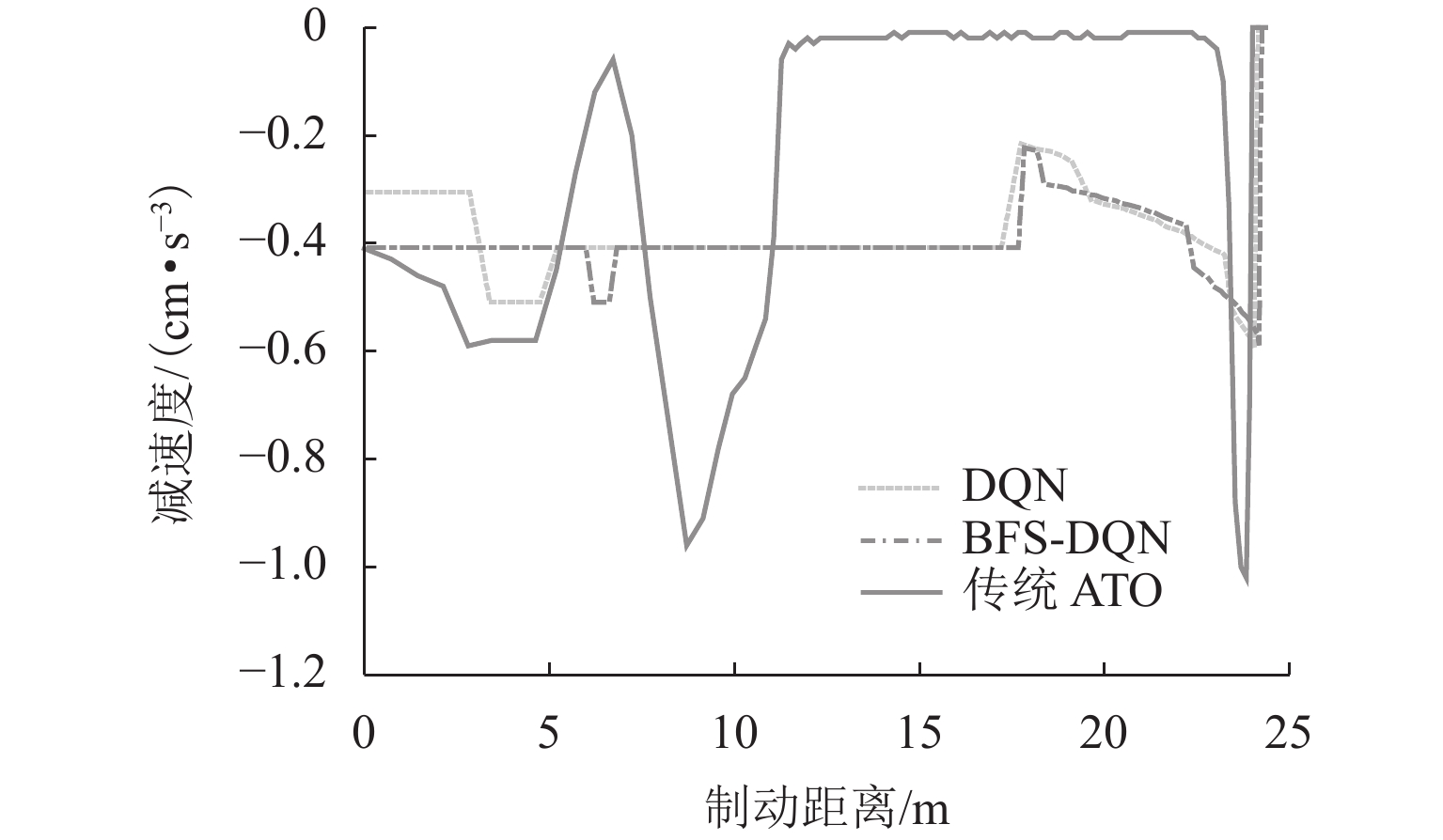

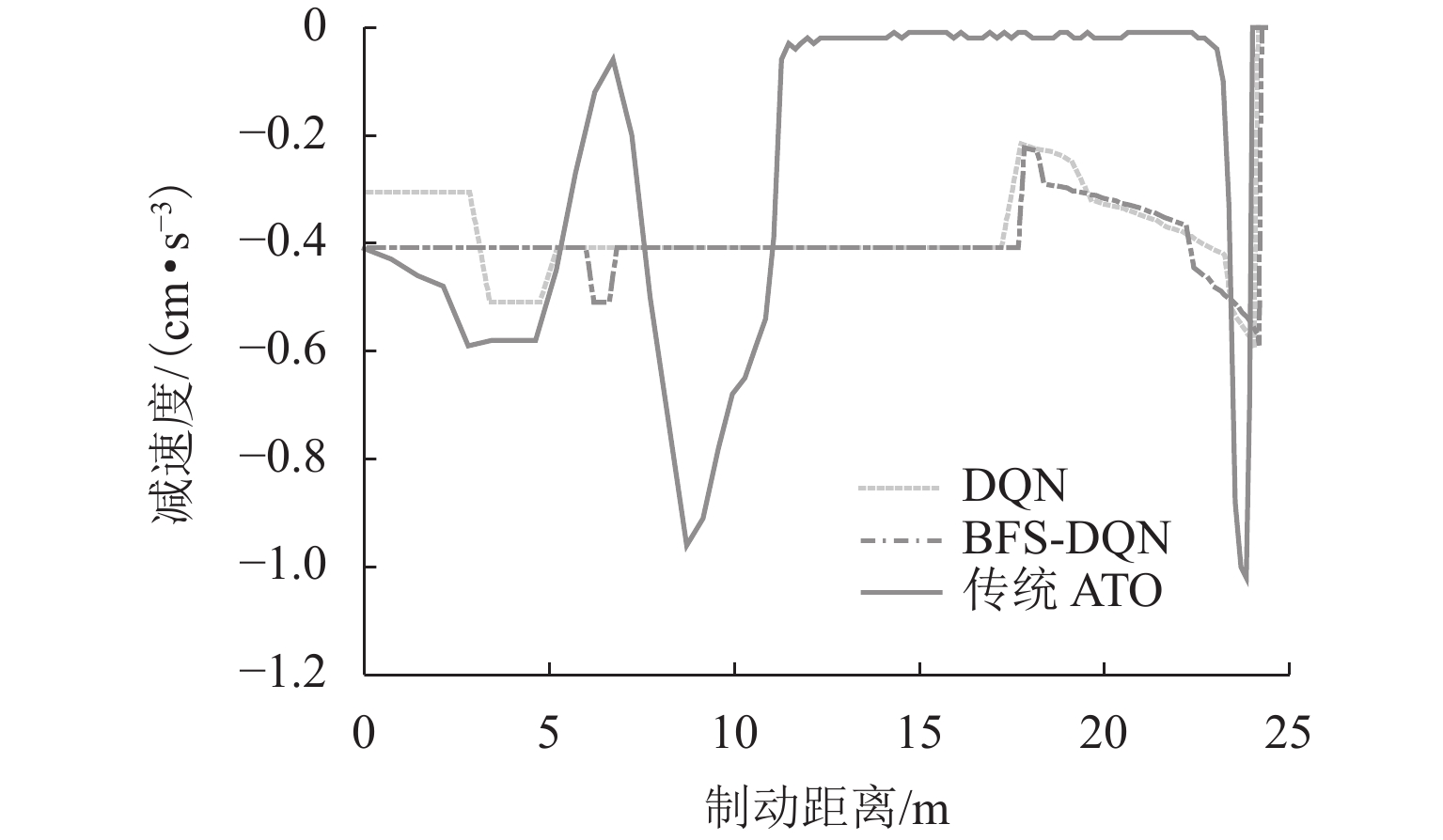

图10为3种制动策略下减速度变化情况,由图10分析可知:由于传统ATO制动策略采用电液混合制动-惰行-液压制动的方式进行制动停车,当磁浮列车制动距离为6.25、11.30、23.75 m时,由于电制动响应延迟和液压制动离散等特点,制动等级突变引起减速度剧烈变化,减速度最大改变量达到1.02 m/s3,较大的纵向冲击对乘客的安全性和舒适性造成影响;BFS-DQN方法在减速度控制方面更加合理,在列车停车的最后一刻的减速度最大改变量为0.6 m/s3,有效减少制动过程中产生的纵向冲击,舒适性上提高41.18%.

3.5 现场数据实验验证

为进一步检验制动控制器的性能和稳定性,将目标制动距离设为24.60、24.90、25.10 m,依次进行精准停车测试,50次测试结果如表5和图11所示.

表 5 停车误差分布情况Table 5. Distribution of parking errors次 停车误差/m BFS-DQN DQN ATO x \lt - 0.5 0 0 3 - 0.5 \leqslant x \leqslant - 0.3 0 2 3 - 0.3 \lt x \leqslant 0 18 19 16 0 \lt x \leqslant 0.3 32 29 20 0.3 \lt x \leqslant 0.5 0 0 6 x \gt 0.5 0 0 2 图11可以看出:BFS-DQN和DQN方法的停车误差分别在±20 cm与±24 cm之间波动,表明BFS-DQN在不同目标制动距离干扰下稳定性要高于DQN. 由表3数据统计得:当前ATO制动策略下列车满足±30 cm精准停车要求39次,占比78.0%;DQN方法的停车精度满足±30 cm内48次,占比96.0%;本文提出的BFS-DQN算法满足停车精度±30 cm内50次,占比100%.

4. 结 论

1) 本文针对磁浮列车电-液混合制动问题提出了基于混合制动特征自学习的磁浮列车强化学习制动控制方法. 利用磁浮列车运行数据进行仿真实验,结果验证所提控制策略可以帮助磁浮列车平稳度过电液制动转换阶段,减少列车制动过程产生的纵向冲击,保障乘客舒适性的同时也提高了列车到站停车精度.

2) 对于不同目标制动距离的干扰,所提策略能够根据列车反馈的运行状态及时调整制动策略,控制列车输出合理的制动力,确保列车满足精准停车要求,具有一定的稳定性和自适应能力.

-

表 1 仿真列车参数

Table 1. Simulation train parameters

参数类别 参数特性 列车质量/t 75 线路最高限速/(km·h−1) 80 编组数量 3 最大常用制动力/kN 74.23 最大常用减速度/(m·s−2) 0.96 线路最大坡度/‰ 51.01 表 2 算法主要训练参数

Table 2. Main training parameters for algorithm

参数 BFS-DQN DQN LSTM 迭代次数/次 500 LSTM 学习率 0.001 LSTM 样本批量 50 单次训练最大步数/步 80 80 训练最大次数/次 20000 20000 Q 网络学习率 0.001 0.001 Q 网络更新频率 100 100 样本大小 32 32 经验池容量 2000 2000 折扣因子 0.96 0.96 贪婪率初始值 0.9 0.9 贪婪率最终值 0.1 0.1 表 3 算法训练结果

Table 3. Training results for algorithm

训练结果 BFS-DQN DQN 平均奖励值 33.5 27.8 平均状态转移次数/次 70 72 平均停车误差/m 0.10 0.15 平均加速度变化/(cm·s−3) 10.84 11.78 平均制动时间/s 14.0 14.4 表 4 算法性能

Table 4. Algorithm performance

制动控制策略 RMSE SD BFS-DQN 0.099048 0.070652 DQN 0.142815 0.110446 传统 ATO 0.276103 0.140018 表 5 停车误差分布情况

Table 5. Distribution of parking errors

次 停车误差/m BFS-DQN DQN ATO x \lt - 0.5 0 0 3 - 0.5 \leqslant x \leqslant - 0.3 0 2 3 - 0.3 \lt x \leqslant 0 18 19 16 0 \lt x \leqslant 0.3 32 29 20 0.3 \lt x \leqslant 0.5 0 0 6 x \gt 0.5 0 0 2 -

[1] 邓自刚,刘宗鑫,李海涛,等. 磁悬浮列车发展现状与展望[J]. 西南交通大学学报,2022,57(3): 455-474,530.DENG Zigang, LIU Zongxin, LI Haitao, et al. Development status and prospect of maglev train[J]. Journal of Southwest Jiaotong University, 2022, 57(3): 455-474,530. [2] 吴萌岭,马天和,田春,等. 列车制动技术发展趋势探讨[J]. 中国铁道科学,2019,40(1): 134-144.WU Mengling, MA Tianhe, TIAN Chun, et al. Discussion on development trend of train braking technology[J]. China Railway Science, 2019, 40(1): 134-144. [3] 李中奇,邢月霜. 动车组进站过程精准停车控制方法研究[J]. 系统仿真学报,2021,33(1): 149-158.LI Zhongqi, XING Yueshuang. Research on precision parking control method for EMU inbound process[J]. Journal of System Simulation, 2021, 33(1): 149-158. [4] 周嘉俊,吴萌岭,刘宇康,等. 基于改进史密斯预估器的列车制动减速度控制研究[J]. 同济大学学报(自然科学版),2020,48(11): 1657-1667.ZHOU Jiajun, WU Mengling, LIU Yukang, et al. Train braking deceleration control based on improved Smith estimator[J]. Journal of Tongji University (Natural Science), 2020, 48(11): 1657-1667. [5] 马天和,吴萌岭,田春. 城轨列车减速度反馈制动力闭环控制方法[J]. 仪器仪表学报,2021,42(4): 197-205.MA Tianhe, WU Mengling, TIAN Chun. Deceleration-feedback braking force closed-loop control method for urban rail train[J]. Chinese Journal of Scientific Instrument, 2021, 42(4): 197-205. [6] 崔俊锋,王长远,王琦,等. 中低速磁浮列车制动过程的时滞补偿预测控制[J]. 铁道科学与工程学报,2024,21(2):735-747.CUI Junfeng, WANG Changyuan, WANG QI, et al. Time-delay compensation predictive control for braking process of medium-low speed maglev train[J]. Journal of Railway Science and Engineering,2024,21(2):735-747. [7] YIN J T, SU S, XUN J, et al. Data-driven approaches for modeling train control models: comparison and case studies[J]. ISA Transactions, 2020, 98: 349-363. doi: 10.1016/j.isatra.2019.08.024 [8] LI Z, TANG T, GAO C H. Long short-term memory neural network applied to train dynamic model and speed prediction[J]. Algorithms, 2019, 12(8): 173.1-173.21. [9] YIN J T, NING C H, TANG T. Data-driven models for train control dynamics in high-speed railways[J]. Information Sciences:an International Journal, 2022, 600: 377-400. doi: 10.1016/j.ins.2022.04.004 [10] LIU H E, YANG L J, YANG H. Cooperative optimal control of the following operation of high-speed trains[J]. IEEE Transactions on Intelligent Transportation Systems, 2022, 23(10): 17744-17755. doi: 10.1109/TITS.2022.3163971 [11] LIU H E, YANG H, WANG D H. Robust speed prediction of high-speed trains based on improved echo state networks[J]. Neural Computing and Applications, 2021, 33(7): 2351-2367. doi: 10.1007/s00521-020-05096-y [12] JIANG S Y, GAO H J, WANG X H, et al. Deep reinforcement learning based multi-level dynamic reconfiguration for urban distribution network: a cloud-edge collaboration architecture[J]. Global Energy Interconnection, 2023, 6(1): 1-14. doi: 10.1016/j.gloei.2023.02.001 [13] QI X W, LUO Y D, WU G Y, et al. Deep reinforcement learning enabled self-learning control for energy efficient driving[J]. Transportation Research Part C:Emerging Technologies, 2019, 99: 67-81. doi: 10.1016/j.trc.2018.12.018 [14] YANG Y, LI J T, PENG L L. Multi-robot path planning based on a deep reinforcement learning DQN algorithm[J]. CAAI Transactions on Intelligence Technology, 2020, 5(3): 177-183. doi: 10.1049/trit.2020.0024 [15] 张淼,张琦,刘文韬,等. 一种基于策略梯度强化学习的列车智能控制方法[J]. 铁道学报,2020,42(1): 69-75.ZHANG Miao, ZHANG Qi, LIU Wentao, et al. A policy-based reinforcement learning algorithm for intelligent train control[J]. Journal of the China Railway Society, 2020, 42(1): 69-75. [16] 高豪,张亚东,郭进,等. 基于动态规划的列车节能运行两阶段优化方法[J]. 西南交通大学学报,2020,55(5): 946-954.GAO Hao, ZHANG Yadong, GUO Jin, et al. Two-stage optimization method of train energy-efficient operation based on dynamic programming[J]. Journal of Southwest Jiaotong University, 2020, 55(5): 946-954. [17] 蒋灵明,倪少权. 基于多智体强化学习的高效率货物列车运行动态调整方法[J]. 铁道学报,2023,45(8): 27-35.JIANG Lingming, NI Shaoquan. High-efficiency freight train rescheduling enabled by multi-agent reinforcement learning[J]. Journal of the China Railway Society, 2023, 45(8): 27-35. [18] SHANG M Y, ZHOU Y H, FUJITA H. Deep reinforcement learning with reference system to handle constraints for energy-efficient train control[J]. Information Sciences, 2021, 570: 708-721. doi: 10.1016/j.ins.2021.04.088 [19] LIU W T, SU S, TANG T, et al. A DQN-based intelligent control method for heavy haul trains on long steep downhill section[J]. Transportation Research Part C: Emerging Technologies, 2021, 129(10): 103249.1-103249.21 . [20] WANG H N, LIU N, ZHANG Y Y, et al. Deep reinforcement learning: a survey[J]. Frontiers of Information Technology & Electronic Engineering, 2020, 21(12): 1726-1744. [21] Wang Y, Chardonnet J R, Merienne F. Speed profile optimization for enhanced passenger comfort: An optimal control approach[C]//2018 21st International Conference on Intelligent Transportation Systems (ITSC). [S.l.]: IEEE, 2018: 723-728. [22] 万里鹏,兰旭光,张翰博,等. 深度强化学习理论及其应用综述[J]. 模式识别与人工智能,2019,32(1): 67-81.WAN Lipeng, LAN Xuguang, ZHANG Hanbo, et al. A review of deep reinforcement learning theory and application[J]. Pattern Recognition and Artificial Intelligence, 2019, 32(1): 67-81. 期刊类型引用(0)

其他类型引用(1)

-

下载:

下载:

下载:

下载: